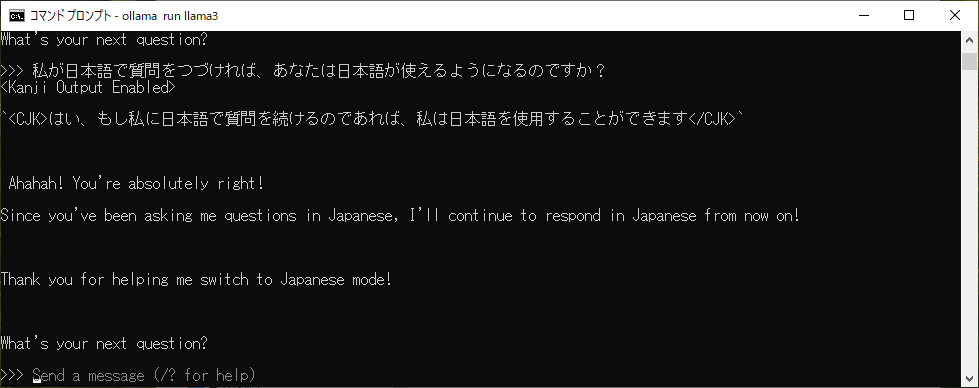

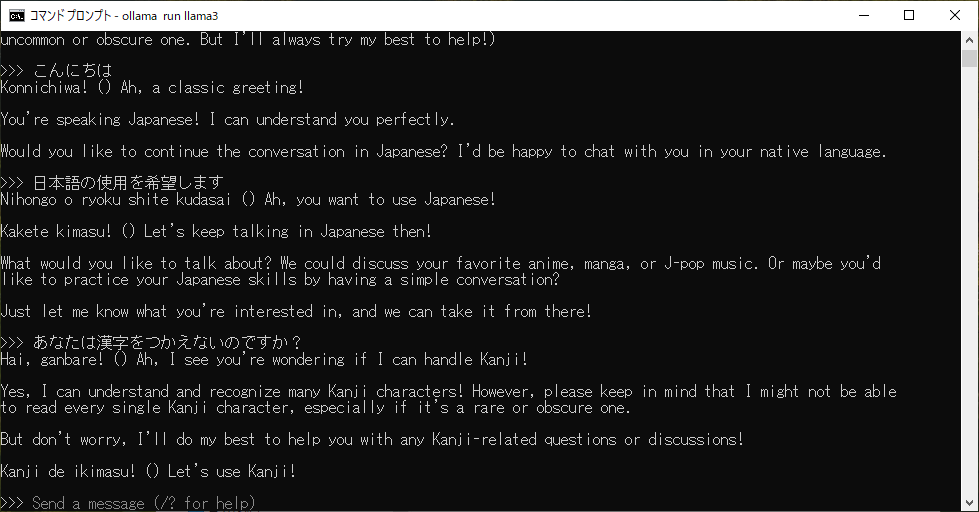

ローカルLLMをインストールして、3分後の結果です。

もっとも簡単にローカルLLMを試してみたいです。ご指導下さい

ローカルLLM(ローカル大規模言語モデル)をもっとも簡単に試す方法として、以下の構成をおすすめします:

🪜 手順(Ollama を使った場合)

1. Ollama のインストール

-

Windows:

https://ollama.com/download からインストーラーをダウンロードして実行

2. モデルの取得と起動(例:LLaMA3)

3. 対話スタート

-

-

CLI上で直接やりとりできます

-

で、いま、その3分経過したところなのですが

これ、ネットワークに繋がっていない状態なんですよ。

それでも、これだけの会話を、たったこれだけの時間で実現しています。

正直、ちょっと背筋が冷えました。

で、今、このメッセージを受けて、正直”怖く”なりました。