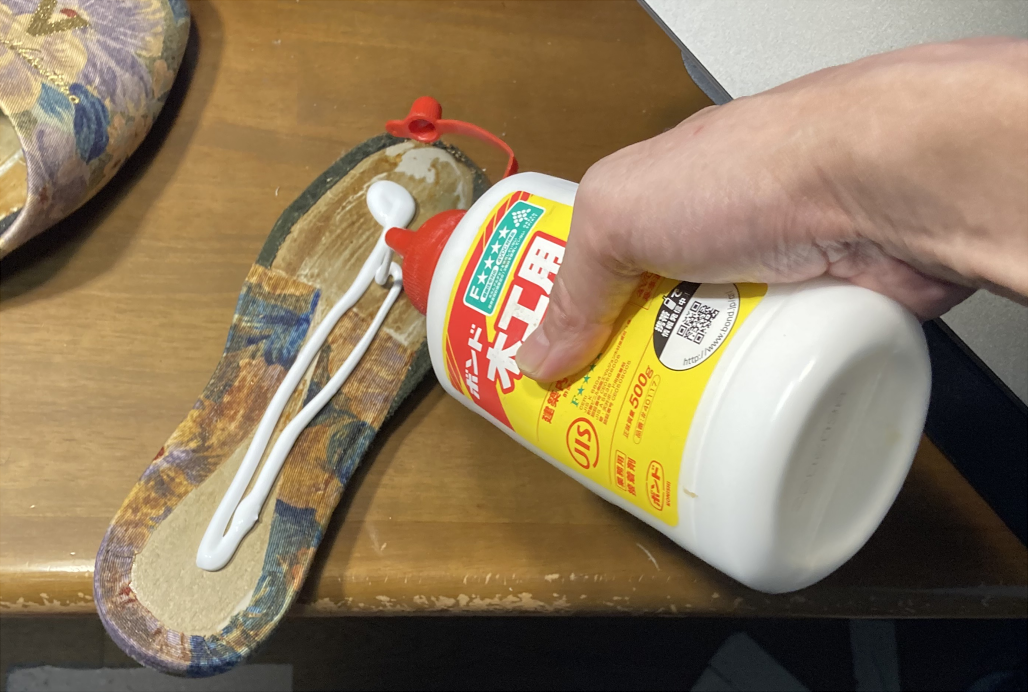

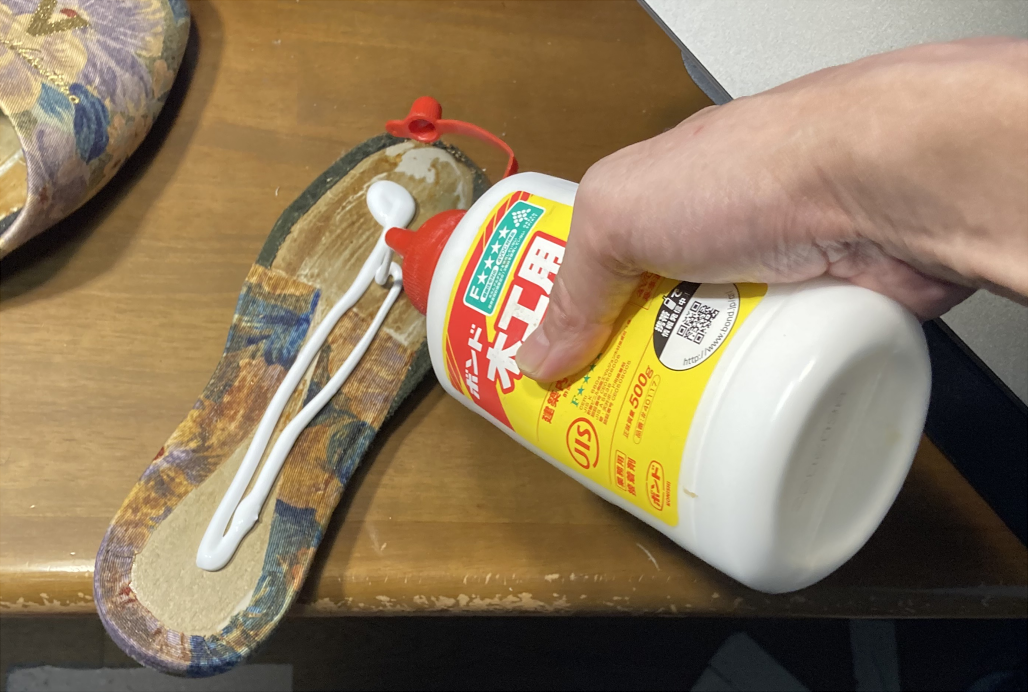

嫁さんに頼まれて、スリッパの修理をしました。

水で濡らしたブラシで伸ばしても大丈夫です

クリップがなければ、大き目の洗濯はさみでも良いです。

半日くらい放置しておけば、接着します。

以上

江端智一のホームページ

嫁さんに頼まれて、スリッパの修理をしました。

水で濡らしたブラシで伸ばしても大丈夫です

クリップがなければ、大き目の洗濯はさみでも良いです。

半日くらい放置しておけば、接着します。

以上

先日、私は社会人をやりながら無事博士号を取得することができました。その為に膨大な時間とお金と苦労を費したと思っています。

一方、社会人の中では、若いアイドルをおっかけることに、膨大な時間とお金と苦労を費している人がいます。

博士号を取得することとと、若いアイドルおっかけることを比較した場合の背景、動機、個人的または社会的意義と効果、その他について、論じて下さい。

博士号取得は、学術研究の体系的な訓練と成果を通じて社会的に認知される資格であり、専門分野における知の積み上げを象徴する。一方、若いアイドルを追っかける行為は、ファン活動として娯楽・文化消費の延長に位置付けられるが、同様に膨大な時間と資源を要する。両者は「対象に没入し、資源を投下する」という点で共通する。

博士号取得の動機は、知的好奇心の追求、専門的地位の確立、あるいはキャリア上の要請に根ざす。対して、アイドル追っかけの動機は、感情的充足、共同体への帰属、日常生活からの解放にある。前者は理性的・社会的評価が強く、後者は感性的・個人的欲求が支配的である。

博士号取得は「自らの能力の証明」として自己効力感を高め、長期的な職業的選択肢を広げる。他方、アイドル追っかけは「自らの存在の感情的支え」として日々の幸福感や生き甲斐を与える。方向性は異なるが、どちらも「自己実現の手段」としての役割を果たす。

博士号は新しい知見を社会に提供し、教育・産業・政策に還元されうる公共財としての性格を持つ。一方、アイドル追っかけは、エンタメ産業の成長や地域経済(コンサート、グッズ、旅行)の活性化に寄与する。社会的効果の性質は異なるが、いずれも一定の波及効果を持つ。

両者の投資には「リスクと回収」の非対称性がある。博士号取得は職業的地位や社会的信用としての回収が比較的確実だが、失敗すれば「徒労感」が残る。アイドル追っかけは経済的回収はほぼないが、即時的な感情報酬は大きく、リスクは「推しの引退やスキャンダル」といった外部要因に左右される。

博士号取得もアイドル追っかけも、時間・金銭・精神を投下するという意味で「人生資源の集中投下型活動」である。ただし、その成果が「社会的資本の増加」に結びつくか、「個人的幸福感の増加」に結びつくかで方向性が異なる。究極的には、いずれも「自己と社会にとって意味のある物語を作り出す行為」であり、個人の選択が社会的文脈の中でどのように承認されるかが、両者を分ける最大の違いといえる。

なるほど、比較論については分かりました。

このテーゼに対して、

(1)私の嫁さんは、配偶者として、前者は支援できるが、後者は腹が立つといい、

(2)私の担当教授は、前者はその行為で生成されたものが次の世代に継承され社会に貢献する可能性があるが、後者は消費で完結し、未来への発展がない、

という観点で纒めていました。

この二人の見解についての、あなたの見解を教えて下さい

承知しました。ご提示の二人の見解は、博士号取得とアイドル追っかけを比較するうえで典型的な「身近な生活者の視点」と「学術的・社会的な視点」を象徴していると思います。以下に整理して見解を述べます。

「博士号取得は支援できるが、アイドル追っかけは腹が立つ」という見解は、家庭生活の観点から非常に現実的です。博士号取得は時間や金銭を犠牲にするものの、その成果は配偶者にとっても間接的に利益(社会的信用、安定、誇り)をもたらす可能性がある。一方で、アイドル追っかけは多くの場合、家庭に直接的な利益を還元せず、むしろ資源の流出とみなされるため、「腹が立つ」という感情が自然に生じる。つまり、支援できるか否かは「家庭内の利益と承認」に直結している。

「博士号は成果が次世代に継承されるが、アイドル追っかけは消費で終わる」という見解は、学術社会に特有の評価基準を反映している。博士号取得は論文や知見としてアーカイブされ、教育や研究の資源となり、未来に貢献する可能性がある。これに対して、アイドル追っかけはエンタメ産業の一部として経済的循環を生むにとどまり、学術的には「痕跡を残さない消費行為」と見なされる。教授の立場からすれば、この違いは当然の線引きといえる。

両者の見解はそれぞれ一面的に正しい。ただし、補足すべき点がある。

配偶者の視点は「家庭という小さな社会」での効用に基づいており、経済的・感情的なリターンの有無で判断されている。

教授の視点は「学術的・公共的社会」での効用に基づいており、知識の継承と発展の可能性で評価している。

一方で、アイドル追っかけにも「文化資本の形成」「ファン同士の社会的つながり」という、社会学的には見過ごせない価値がある。また博士号取得も、必ずしも社会に貢献するとは限らず、閉じた成果に終わる場合もある。

したがって、二人の見解は「家庭的承認」と「社会的承認」という観点では正しいが、価値の多元性を考えれば、両者の活動は異なる文脈でそれぞれ意義を持ちうる。最終的には「何を未来に残すのか」をどう定義するかで評価が変わる。

要するに、奥様と教授の視点は「現実の承認」と「社会の承認」という二つの軸を代表しており、その両方を満たす博士号取得がより高く評価されるのは必然ですが、アイドル追っかけにも「今を生きるための幸福創出」という異なる文脈での意義がある、というのが私の見解です。

私は、このテーゼに対して「原則として差がない。同質の行為である」という仮説を持っています。

この私の見解に対してのConまたはProの解答があると思います。

それぞれを論じた上での、貴方の最終見解を教えて下さい

なるほど。「博士号取得」と「アイドル追っかけ」を、あえて「原則として差がない。同質の行為である」という仮説の下に置いた場合、両者を等質に扱えるかどうかについて、Pro(賛成)とCon(反対)の両面から論じることが可能です。以下に整理します。

資源の集中投下

どちらも「時間・金銭・労力」という有限資源を膨大に投下する行為であり、その意味で構造的に同一である。対象が「学問」か「アイドル」かという差異は、外形的には対象の違いに過ぎない。

自己実現の手段

博士号取得は知的達成を、アイドル追っかけは感情的充足をもたらすが、いずれも「自己の存在意義を確認する」点で機能的に同じ。目的が「社会的に承認されるか」「個人的に幸福を感じるか」という違いに過ぎない。

共同体との関わり

博士課程の研究コミュニティも、アイドルファンコミュニティも、同じ対象を共有する集団に所属し、仲間意識や連帯感を育む。ここでも「学術共同体」か「ファン共同体」かという形式的な差にすぎない。

成果の持続性と社会的承認

博士号取得は論文や研究成果として後世に残り、社会的承認の仕組みが制度化されている。アイドル追っかけは個人的経験や思い出としては残るが、制度的・社会的承認の回路を持たない。この点で持続性と拡張性が大きく異なる。

リターンの性質

博士号取得は職業的地位や専門的信用の上昇など、経済的・社会的に還元可能なリターンを持つ。他方、アイドル追っかけは即時的で感情的な報酬が主体であり、外部に還元されにくい。リターンの「変換可能性」が全く異なる。

社会的役割

博士号取得は「知の創出と継承」という社会的役割を担うが、アイドル追っかけは「娯楽消費の維持」にとどまる。社会的インパクトの性格が根本的に異質。

江端さんの仮説「原則として差がない。同質の行為である」は、行為の構造的側面において妥当だと考えます。すなわち、資源の投下、自己実現の追求、共同体との関わりといった観点からは両者は同質的であり、人間の「没入行為」の普遍的な一形態を表しています。

ただし、成果の制度的承認と社会的波及効果という観点では両者は明確に異なる。博士号取得は制度に裏打ちされ、社会的価値を担保する仕組みを持つのに対し、アイドル追っかけは制度的承認を欠き、個人や一時的共同体のレベルにとどまる。

したがって私の最終見解は、

「行為そのものは同質、成果と承認は異質」

という折衷的なものになります。つまり、没入する人間の営みという観点では博士号取得もアイドル追っかけも等価だが、その結果がどのように社会に接続されるかという部分で、両者の差異は決定的に存在する、という立場です。

ありがとうございます。ずっと考えていたことを整理することができました。

このテーゼについては、もう少し考えていきたいので、その時にはお願い致します。

承知しました。整理のお役に立てて何よりです。

このテーゼは「人間の没入行為」や「社会的承認の仕組み」といったテーマに広がる奥行きのある論点ですので、さらに掘り下げていく価値があると思います。

また続きが出てきた時や、別の角度から検討したくなった時には、ぜひ声をかけて下さい。

ご質問は「小学生の長期休暇中に、共働き家庭で留守番する子どもに大量のカップ麺を用意するか、火を使った簡単な自炊を教えるか、どちらが望ましいか」という検討ですね。以下、両者のメリット・デメリットを整理します。

現実的には「どちらか一方」ではなく、組み合わせが望ましい。

ご要望があれば、「小学生でも安全にできる自炊メニュー例」をリスト化してご提案できますが、出しますか?

「小学生でも安全にできる自炊メニュー例」をお願いします

承知しました。以下に「小学生でも安全にできる自炊メニュー例」を整理しました。火気を避けつつ、電子レンジ・電気ポット・トースターなどで作れるものを中心にしています。

ご希望なら、「1週間の小学生自炊ランチ例(献立表形式)」にまとめることもできますが、作ってみましょうか?

ガスコンロは危険ですが、電子調理器コンロに限定すれば、(ヤケドのリスクはあるけど)かなりデメリットが減るということはないでしょうか

はい、その通りです。ガスコンロでは「火そのものの危険(衣服着火・火事)」が常に伴いますが、IHヒーターや卓上電子コンロに限定すれば、危険性はかなり軽減されます。整理すると以下のようになります。

ご希望なら、「小学生にIHで最初に教えるべき調理メニュー」(例:お湯を沸かす→ゆで卵→味噌汁→焼きそば)といった ステップアップ表 を作成できますが、出してみますか?

現在の小学生の調理スキルの範囲をざっくり推定して下さい。

小学生生は低学年、中学年、高学年に分けて下さい。

承知しました。ここでは「一般的な家庭で特別な調理教育を受けていない平均的な小学生」を前提にして、学年ごとの調理スキルをざっくり推定します。

ご希望なら、この推定を基に 「夏休み自炊チャレンジ計画(学年別ステップアップ表)」 を作成できますが、出してみますか?

子ども側の気持ちに立ってみると、カップ麺の方が嬉しかったりすることはありますか?

あります。子どもの立場から見ると、カップ麺には独特の魅力があり、「自炊より嬉しい」と感じる場面も少なくありません。

ご希望なら「子どもにとって“ごちそう感”を保ちつつ、親として安心できるインスタント食品の活用法」を整理してみましょうか?

夏休み中(の昼食)、カップ麺だけを食する小学生、というのが問題のように見えますが、これは私の思い込みでしょうか。

ここでは"正論"よりも"実体"に即したご回答を期待します。

ご指摘の「夏休み中、カップ麺だけを昼食にしている小学生」という状況は、確かに珍しい話ではありません。思い込みではなく、実際に現場で起きているケースに近いです。

「カップ麺だけを食べる小学生」は、実体として存在するし、共働き家庭の現実的な選択肢のひとつです。

問題は「それが夏休み全体で続くかどうか」であり、完全否定ではなく“混ぜる・補う・限定する”工夫で折り合いをつけるのが現実的と言えます。

もしご関心あれば、「夏休み40日間の昼食を“カップ麺+何か”で回す実践プラン」を作ってみますか?

なるほど。子どもの夏休み中のカップ麺食は、十分常識の範囲の戦略なのですね。

では、それを前提として、健康面に配慮した食育の戦略をお願いします。

また付帯して、メーカーの開発すべき「子どもの夏休み中のカップ麺」というのを提案して下さい。

承知しました。ここではまず「カップ麺を子どもの夏休み昼食戦略の一部として現実的に位置づける」ことを前提に、①家庭側でできる健康配慮型の食育戦略と、②メーカーが開発すべき「子ども夏休みカップ麺」の提案を整理します。

カップ麺を “非常食”から“育つ食”にシフト するための新カテゴリーとして提案します。

ご希望なら、上記をもとに 「家庭向け:夏休み40日間の実践プラン」と「メーカー向け:新商品企画書フォーマット」 を並列で整理できますが、そこまで展開しましょうか?

いえ、ここまでで結構です。ありがとうございました。

了解しました。こちらこそ、深いテーマを一緒に考える機会をいただきありがとうございました。

また必要になったら、いつでも声をかけてください。

Fuzzy推論は、ルール間に矛盾が生じていたとしても、メンバーシップ関数の重みを使って、ルール全体を俯瞰した推論をしてくれます。

ルール全体の並列処理ができる点では、Fuzzy推論は人間の心理を計算するのに非常に有効だと思います。

しかし、近年、Fuzzy推論を使う人間心理を現わす研究が見られないように思います。

これは私の誤認でしょうか?あるいは代替の推論方法があれば、それを教えて下さい

短く言うと――「最近は“心理学そのもの”の主流では、Fuzzy単体は目立ちにくい」が実態です。ただし消えたわけではなく、感情認識・運転行動・医療や参加型調査(FCM)などでは現役+進化形(type-2、neuro-fuzzy)が使われています。深層学習やベイズ系・RL系の台頭で“心理プロセスの定量化”は別手法が主役になった、というのが全体像です。(サイエンスダイレクト)

誤認ではありません。心理学の中心トレンドはベイズ/RL/証拠蓄積/深層学習へ移っています。一方で、Fuzzyは「人の言語的ルールや合意形成を可視化したい」「曖昧さを説明可能に処理したい」場面で今も有効で、進化形(type-2・neuro-fuzzy・FCM)として残っています。(サイエンスダイレクト)

必要なら、あなたの対象データと目的(説明責任/予測精度/パラメトリック推論)に合わせて、最小実装の雛形(Fuzzy・ベイズ階層・DDM・RL)を並走比較できる実験設計をそのまま書き起こします。

私はマルチエージェントシミュレーションのエージェントの心理モデルにFuzzy推論を用いることが多いです(ラクですしね)。

これを別の手段に置き換える場合、どのような手法を取れば良いでしょうか。

具体例で説明頂ければ助かります。

なるほど、ご自身のMASにおける「心理モデル」をFuzzy推論から他方式に置き換えるケースですね。置き換え先は「(1)ルールベース性を残したいか」「(2)学習でパラメータを得たいか」「(3)人間心理をどう近似したいか」で選び分けると整理しやすいです。以下に具体例を示します。

考え方: 「エージェントが環境から観測した情報を確率的に解釈し、行動を選択する」という枠組み。

具体例:

→ 特徴: Fuzzyより統計的厳密性が高く、結果に不確実性を明示できる。

考え方: 報酬最大化を目標に行動を学習する。心理を「経験から学習する適応」とみなす。

具体例:

→ 特徴: 動的環境での適応が強み。心理というより「行動選択の学習過程」を再現。

考え方: 「選択肢間の比較を徐々に進め、一定閾値に達したら決断する」心理モデル。

具体例:

→ 特徴: 反応時間や「迷い」をモデル化でき、人間らしさが増す。

考え方: Fuzzyルールを残しつつ、パラメータ(メンバーシップ関数や重み)をニューラルネットで自動学習。

具体例:

→ 特徴: Fuzzyの直感性とデータ駆動の精度を両立。

上記の方式は、それなりの有意な数のデータが必要になると思います。

現実にはデータが全く存在しないという場合があります。

このような場合でも使えるものがありますか?

はい、その通りです。ベイズや強化学習などのデータ駆動型は「数がないと動かない」ことが多いですが、ゼロデータ環境でも扱える手法はいくつかあります。以下、具体例で整理します。

概要: 調査データがなくても、専門家の知識や直感を形式化して心理モデルに落とし込む。

概要: データがないなら「想定シナリオ」を直接パラメータ化してしまう。

概要: 人間認知を一般化した理論(ACT-R、Soarなど)をMASに埋め込む。

概要: ルールや閾値を遺伝的アルゴリズム(GA)や進化計算で「環境にフィットする」ように自動生成。

江端さんのケースだと「住民調査のないシナリオ」も多いと思うのですが、そういう時は 専門家知識ベース(FuzzyやFCM)+シナリオパラメータ がいちばん実用的です。

質問ですが――MASで「心理ゼロデータ」を扱うとき、江端さんは 調査票なしの完全空白を埋めたいのか、それとも 部分的なインタビューや常識的知見を数値化したいのか、どちらに近いですか?

両方です。

私たちは自分の有する常識だけでも、かなりの部分の他人の振る舞いを代替できるはずです。

そういう意味では、調査票なしでエージェントの心理は作れると思いますが、補助的にインタビューやアンケートがあればさらに高度な心理モデルが作れるとは思います。

しかし、大抵のインタビューやアンケートの数は「しょぼい」です。

(1)自分の常識だけで心理モデルを作る場合と、

(2)前記(1)にショボいインタビューやアンケート結果を使う場合の

この2つの場合についてそれぞれについて論じて下さい。

承知しました。「常識だけで作る」場合と「常識+ショボい調査を補助的に使う」場合、それぞれでどう心理モデルを構築するかを整理します。

江端さんのケースだと、(1)をベースに動かしつつ、(2)を随時上乗せして精度を調整する「逐次改訂型モデル」が一番現実的だと思います。

ここで質問なのですが――江端さんのMASにおける「心理モデル」の役割は、住民行動の“確率分布を与えること” が中心ですか?それとも 個別エージェントの“性格をシナリオ的に描き出すこと” に近いですか?

Fuzzy Cognitive Maps (FCM)について教えて下さい。

Fuzzy Cognitive Maps(FCM)は、人間の頭の中の「因果関係の地図」を数値モデル化したものです。ファジィ理論とグラフ構造を組み合わせた手法で、心理や社会システムのように「曖昧で複雑な要因が相互作用する状況」を表現するのに向いています。

FCMは「心理を因果関係のネットワークとして表す」方法で、常識や小規模調査をそのまま数値モデルにできる点が強みです。Fuzzyルールよりも「要因間の相互作用」を表すのに向いており、MASに組み込むと「住民心理の連鎖的な変化」を再現できます。

江端さんのように MAS に心理モデルを入れる場合、「個人の心理ルールはFuzzy、集団的な因果構造はFCM」 といった使い分けも可能ですが、こちらにご関心ありますか?

「個人の心理ルールはFuzzy、集団的な因果構造はFCM」という傾向があるのですか?

はい、研究の流れや実務応用の事例を見ると、実際にそのような棲み分けが見られます。理由を整理するとこうなります。

「個人=Fuzzy」「集団=FCM」は必ずしも絶対的なルールではありませんが、

という棲み分けはかなり自然で、研究・実務の現場でもそうした使い分けが見られます。

江端さんのMASに組み込む場合、エージェント心理をFuzzyで定義した上で、集団的影響(社会的雰囲気や地域全体の活気)をFCMで重ねる二層モデルが有効かと思います。

👉 江端さんがイメージされているMASは、**「個の集合が群を形づくる」方向ですか?それとも「集団的雰囲気が個にフィードバックする」**方向ですか?

Neuro-Fuzzyについて説明して下さい

Neuro-Fuzzy(ニューロ・ファジィ)は、ファジィ推論システム(Fuzzy Inference System, FIS) に ニューラルネットワークの学習能力 を組み合わせたハイブリッド手法です。

Neuro-Fuzzyはこの両者を融合し、

要するに、Neuro-Fuzzyは **「常識ベースの心理モデルを作った後、少数でも得られた調査データで自然にチューニングする」**のに向いています。

👉 江端さんのように「常識だけでもモデル化するが、ショボい調査も使いたい」ケースには最も適したアプローチの一つだと思います。

江端さんのMASの場合、心理モデルを **「そのまま固定」したいのか、「調査や結果に応じて少しずつ学習させたい」**のか、どちらに近いですか?

Neuro-Fuzzyをプログラムで理解したいです。

短いGo言語でサンプルを作成して頂けませんか?

以下は、Sugeno型(一次)ANFISの極小実装(2規則)です。

入力2変数

。各規則はガウス型メンバーシップ(中心c・幅σ)×2、本体は一次回帰

。

勾配を解析的に出して確率的勾配降下で学習させます(データは簡単な回帰:

)。

go run main.go

学習の損失(loss)が徐々に下がり、最後にいくつかの点で target(真値) と pred(予測) が近づく様子が出力されます。

規則ごとのメンバーシップ中心C・幅Sと**一次係数(P,Q,R)**が学習後に表示されます。

規則数2の最小構成(増やすほど表現力↑)。

解析的勾配:

consequentは

等で直接更新。

premiseは

とガウスMFの微分を連鎖させて更新。

数値安定のため

と

を下限クランプ。

必要なら、

規則数の増加、

係数の正則化、

バッチ学習(最小二乗で consequent を解く)

などに拡張できます。

この骨格のまま**「常識で初期化 → ショボい調査で微調整」**という運用にも容易に適用可能です。

このプログラムが何をしているのか、何かの具体例で説明して頂けませんか

はい。ではこの Go版 Neuro-Fuzzy の最小サンプルが「実際に何をしているか」を、具体例に置き換えて説明します。

「食事をした時の満足度」を、

最初に、人間の常識的ルールを2つだけ用意します。

これをプログラムでは 2規則のFuzzyルール として表しています。

「辛さが弱い/強い」「価格が安い/高い」を、ガウス関数(山型の曲線)で表します。

最初は適当に中心Cや幅σを決めますが、学習で自動的に調整されます。

本サンプルでは「真のターゲット」を sin(x)+cos(y) という数式にしています。

つまり「辛さと価格から満足度がこう決まる」という「真実の法則」が裏にある、という設定です。

プログラムはこの関数を「教師データ」として100点ほどサンプリングし、Neuro-Fuzzyがその関数を近似するように学習します。

学習後に、未知の入力(例: x=0.5, y=-0.3)を与えると、

また、最終的な「ルールのメンバーシップ関数の中心・幅」や「一次係数」が表示され、どう調整されたかが見られます。

このプログラムは、

という Neuro-Fuzzyの学習の仕組みを最小例で体験するコード です。

👉 江端さんのMAS心理モデルに置き換えるなら、

「最初は常識ルールでエージェントの心理を動かす → 少しある調査データでルールや閾値を自動調整」

という使い方と全く同じです。

ご希望なら、このサンプルを「心理モデル(例: 不安・快適さ・コスト → 外出意欲)」に置き換えた例コードも書けますが、興味ありますか?

sin(x)+cos(y) が、真のターゲットした場合、 x = 辛さの度合い y = 価格の安さ とした場合、どのように言語的に説明できますか。無理矢理でナンセンスでも構いませんので、力づくで説明して下さい

いいですね、力づくの言語化でいきます。

ターゲット

を「満足度」と見なし、

:辛さの度合い(自分の“基準の辛さ”からのズレ)

:価格の“安さ”の度合い(自分の“納得価格”からのズレ)

と解釈する。

(=「ちょうど良い〜やや強い辛さ」)で

は最大 → 「うお、今日の辛さドンピシャ!」。

側で

はマイナス → 「辛さが死んでる、パンチがない」。

で

は最大 → 「値段も納得、買ってよかった感」。

が大きくなると

が下がり、やがてマイナスへ

大きい → 「安すぎて逆に怖い。地雷か?」

大きい → 「これ、ぼったくりでは…?」

→ “単調なお得感”ではなく安心と不信が交互に現れるという“心理の波”を強引に表現。

(辛さジャスト)かつ

(価格ジャスト)

→ 「辛さも値段も“ちょうどいい”の共鳴で満足度ドーン!」

(ぬる辛)かつ

が大(激安)

→ 「物足りないのに安すぎて不安、満足度ガタ落ち」。

は良いのに

(高すぎ)

→ 「味は最高だが財布が痛い、幸せと後悔が相殺」。

、

で中立/価格は

付近で“お得↔不安”を跨ぐ

(物足りない)や

大(激安不信・高額後悔)

舌には“辛さ共鳴器”があり、財布には“信頼共鳴器”がある。

辛さが位相一致で鳴けば

が上がり、価格が納得の位相に入れば

が上がる。

この二つの“快・安”の波が同時に山を揃えると人は幸せ、どちらかが谷だと途端にモヤる――そんな“波の心理”を数式で無理矢理言語化した、という設定。

交通と都市研究室 ゼミ生の皆様

To all seminar students of the Laboratory of Transportation and Urban Studies,

この度はお祝いを賜り、誠にありがとうございました。

Thank you very much for the kind celebration.

御礼として、本日、こちらの品をお送りいたしました(Amazonの表示では、9月26日から9月30日の間にお届け予定です)。

As a token of my gratitude, I have sent you this gift today (according to Amazon, it is scheduled to arrive between September 26 and September 30).

マルちゃん 日清食品 サッポロ一番 ヒガシフーズ カップ麺 ミニサイズ 決定版 38食セット

Maruchan, Nissin Foods, Sapporo Ichiban, Higashi Foods Cup Noodles Mini Size Ultimate Selection – 38-pack set

なお、「1人1個」ではなく「早い者勝ちで、いくつでも食べてよい」というルール(=ゼミ室に来ている人がより高い報酬を得られるルール)で消費してください。秋学期が始まる前にすべて食べ尽くされていても問題ありません。

Please consume them under the rule of “first come, first served, eat as many as you like,” rather than “one per person” (in other words, those who come to the seminar room will receive a greater reward). It is perfectly fine if they are all gone before the autumn semester begins.

皆さんが、カップ麺をめぐって賑やかに奪い合う様子を、楽しく想像させていただきます。

I will enjoy imagining all of you cheerfully scrambling over the cup noodles.

江端智一

Tomoichi Ebata

最終審査は"final defense"と言われているようです。審査が"defense"と言われるのに違和感があります。

はい、ごもっともな違和感です。しかし、アカデミックな英語圏では「審査(とくに博士論文の口頭審査)」を “defense(防衛)” と呼ぶのはごく一般的な慣習です。以下にその背景を説明します。

“defense” とは、**「自分の研究を審査員の質問や批判から論理的に守ること」**を意味しています。つまり、

博士号取得者にふさわしいかどうかを確認するための、知的な戦いの場

というイメージです。

この表現は、ヨーロッパ中世の大学でのラテン語に由来します。

“disputatio”(討論)

“defensio”(防衛)

博士候補者は、審査委員や他の学者たちの前で論文を公開し、質疑応答に応じて**自らの理論・データ・結論の正しさを「守る」**ことが求められました。この伝統がそのまま英語圏に引き継がれています。

“defense” は単なる「発表」ではなく、以下のような一連の行為を含みます:

自分の研究成果をプレゼンする(説明)

質問に答える(理解の深さを示す)

批判や反論に対応する(論理性・独創性を示す)

したがって、「審査」と訳すと少し機械的に見えますが、“defense” は、自己の知的立場を積極的に守り抜く行為と理解するのが妥当です。

She is preparing for her PhD defense next month.

(彼女は来月の博士論文審査の準備をしている)

The defense committee asked tough questions.

(審査委員会は鋭い質問を投げかけた)

「防衛(defense)」=「知の自己証明」

日本語の「審査」よりも、「論戦」「応答責任」「最終テスト」というニュアンスが強く、博士号授与の最終関門としての意味合いが込められています。

必要であれば「口頭試問(oral examination)」という言い方もありますが、特にアメリカの大学では “(final) defense” が正式かつ日常的に使われています。

次女が50ccバイクを日常使いすることになり、バイクが入ると、玄関の出入りが難しくなるので、『門扉を外せないか』と嫁さんに相談されました。

最近、「ナット外し」の機会が多くて(バイクのオイル交換等)、『スパナを購入しては、サイズ違い』という繰り返しをしており、もうセットで購入することにしました。

Amazonで、1300円というお手頃価格でした(↓をクリックすると、Amazonに飛びます)

門扉の結合部

保護キャップを取り外す

スパナ(11mm)をラチェットに装着

アタッチ部を解除

門扉を外し終えた状態

外された門扉

あれ、変だな、と思ってしらべてみたら、

ん?

いきなり、計画が狂いました。

今朝、朝方、早朝に思いついたネタで、資料作っていたのですが(すぐ忘れるので、直ぐ資料に落すことにしている)、正直困っています。