今、新幹線の新横浜駅にいます。

I'm at Shin-Yokohama Station waiting for the Shinkansen.

出発1時間半前です。

It's an hour and a half before departure.

正直、安堵で腑抜けているところです。

Honestly, I'm feeling utterly relieved and drained.

-----

私の勤務している会社では、会社が発行したクレジットカードを用いた新幹線チケットの購入が認められなくなりました。

At my company, we're no longer allowed to buy Shinkansen tickets using company-issued credit cards.

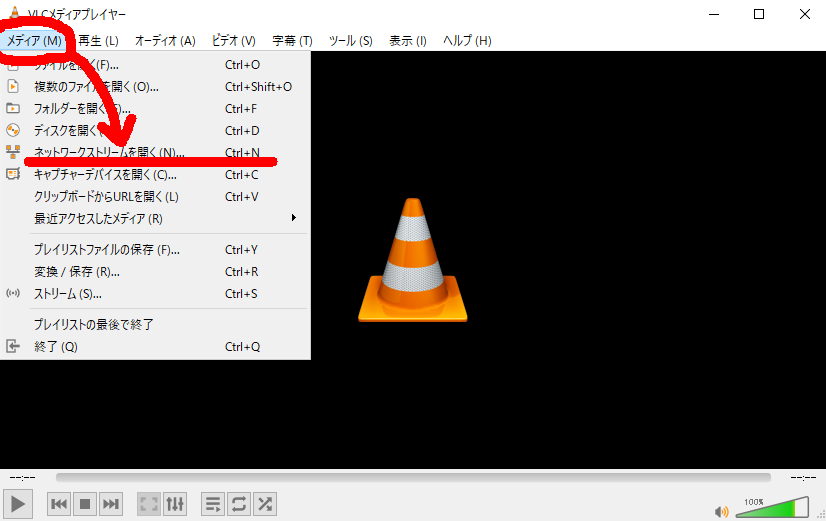

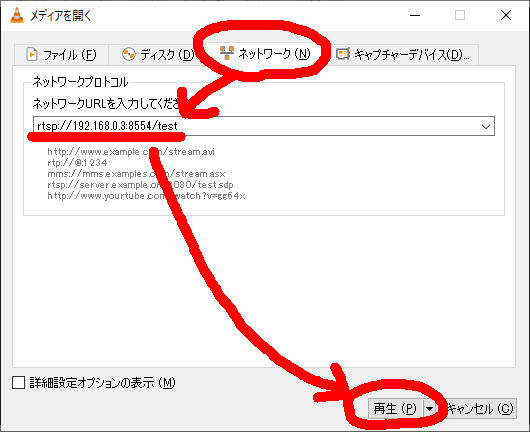

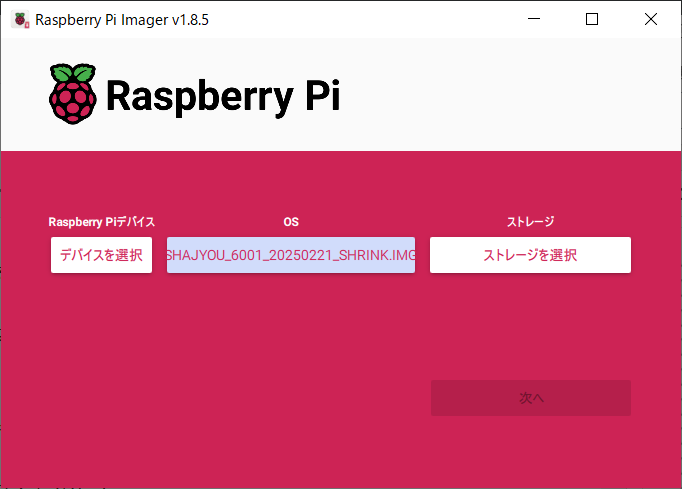

代わりに、「JR東海エクスプレス予約」というサービスを、会社のシステム経由で使わなければならなくなり、さらに『早割○○○』でのチケット購入が必須となりました。

Instead, we are required to use the JR Central Express Reservation system via our company system and purchase tickets under special advance-discount plans.

出張というのは、現場で何が起きるかわかないものです。

Business trips are unpredictable by nature.

人身事故がなくても、遅延や遅着は当たり前。

Delays and late arrivals are common even without personal injury accidents.

鉄道を止める規模の地震は、日本各地で週単位で発生しています。

Earthquakes large enough to halt train services occur somewhere in Japan almost every week.

加えて、豪雪・豪雨は、もはや日常レベルです。

Additionally, heavy snow and rain are frequent occurrences.

つまり、チケット予約は「怖い」のです。

In short, booking tickets is a nerve-wracking affair.

いや、チケット予約そのものはどうということはありません。

The act of booking itself isn’t the problem.

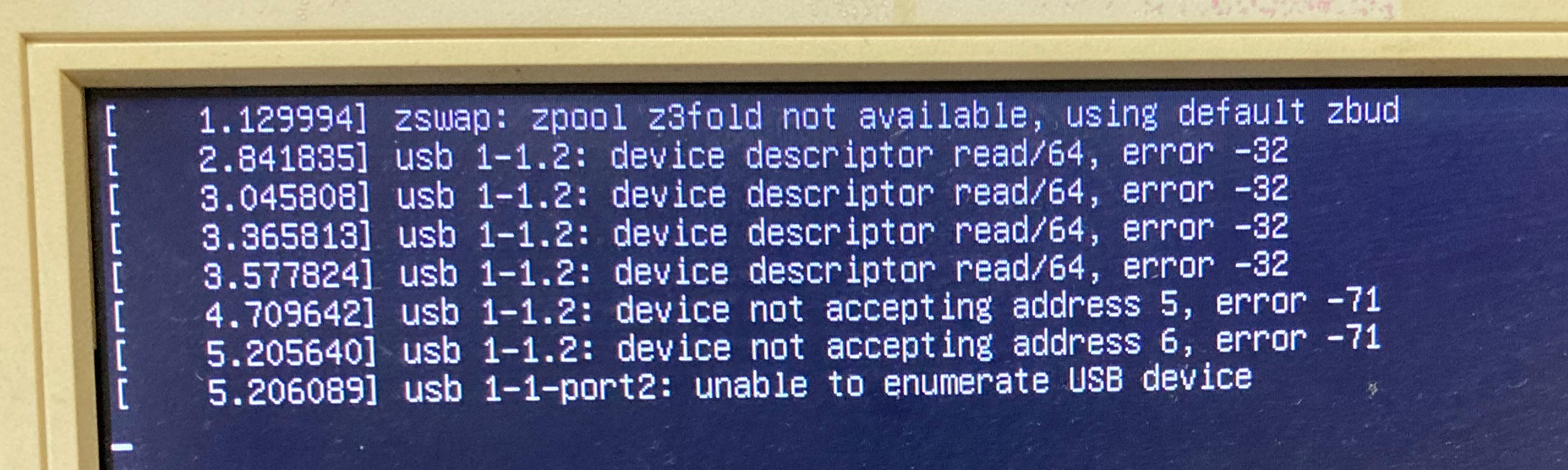

怖いのは、予測不能の事態が発生したとき、ネット経由のチケットキャンセルが、ほぼ100%の確率で失敗することを、私は経験として知っているからです。

What scares me is the near-certainty that online ticket cancellations will fail during unforeseen events—something I know from painful experience.

キャンセルができなかった場合の「損金処理」の始末が、地獄のように面倒くさい。

Handling the accounting for unused tickets when cancellation fails is a nightmare.

これだけで、2日分の通常業務を吹き飛ばすくらいの時間がかかります。

It can eat up the equivalent of two full days’ worth of regular work.

なぜ、このようなことになるのか。

Why does this happen?

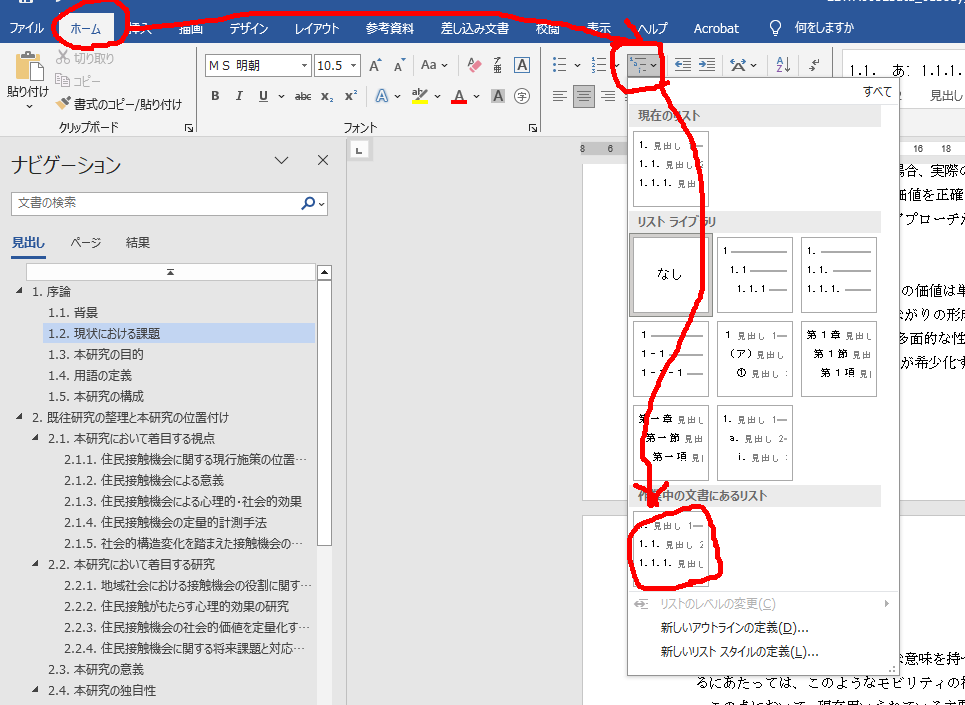

―― システム(のUI:ユーザーインターフェース)が、絶望的にアホだからです。

Because the system UI—the user interface—is hopelessly stupid.

-----

ANAのチケット予約システムも含めて、大抵の予約システムのUIはアホで、

Including ANA's flight reservation system, most booking UIs are simply idiotic.

特にキャンセルや解約に関しては、

Especially when it comes to cancellations and contract terminations,

―― 意図的に手続を妨害しているとしか思えないUI設計

—The UI seems deliberately designed to obstruct the process.

になっています。

That's how it feels.

キャンセルや解約の手続きは、トップページの先頭に、ワンボタンで配置すべきです。

Cancellation and termination options should be a one-click button at the top of the homepage.

(実際、私は町内会のホームページをリメイクしたとき、トップページに脱会用PDFのリンクを貼るようにデザインしました)

(When I redesigned our neighborhood association website, I made sure to put a link to the withdrawal form PDF right on the homepage.)

-----

最近思うのですが、ホームページのデザインにも、製作者の名前(×法人名、○個人名)を表示するべきではないでしょうか。

Lately, I think that website designs should include the actual designer’s name, not the company, but the individual.

アホなUIを設計したWebデザイナーは、業界から嘲笑され、顧客から憎悪される

A web designer who builds a foolish UI should be ridiculed by the industry and hated by users—

――これくらいのフィードバックがない限り、我が国のUIデザインは、これからも"アホ"を続けることになります。

—Without that level of feedback, Japanese UI design will remain forever idiotic.

というか、新幹線の予約システムも、異なるシステムを5つくらい作ればいいんです(5つの会社に発注する)。

Honestly, they should build five separate Shinkansen reservation systems, each developed by a different company.

そうして、アホなUIのWebは競争的に淘汰されるようになればいい。

That way, the dumb ones would be weeded out through competition.

(……と書きながら、排他制御やセキュアなデータ管理を考えると、それが現実的に難しいことも理解してはいるのですが)

(Though I say that, I also understand the practical challenges like exclusive access controls and secure data management.)

-----

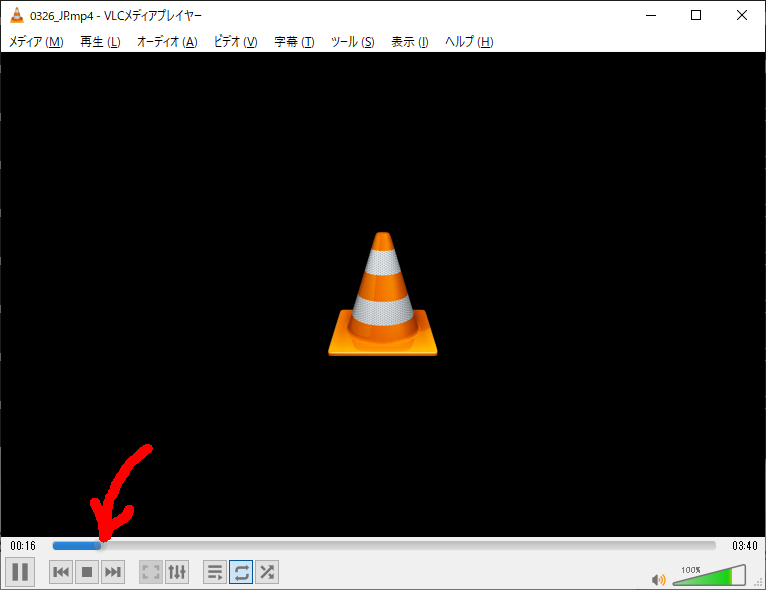

今、私が新横浜駅の新幹線ホームで安堵して腑抜けている理由は、

Now, the reason I'm standing limp with relief on the Shinkansen platform at Shin-Yokohama Station

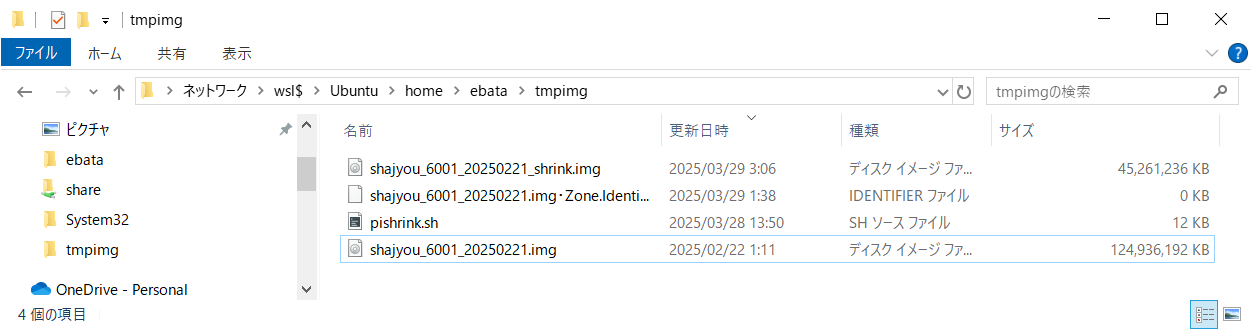

―― JR東海エクスプレス予約と私のPASMOとの紐付けが成功していることを、改札で確認できたからです。

—I confirmed at the gate that my JR Express Reservation was successfully linked to my PASMO card.

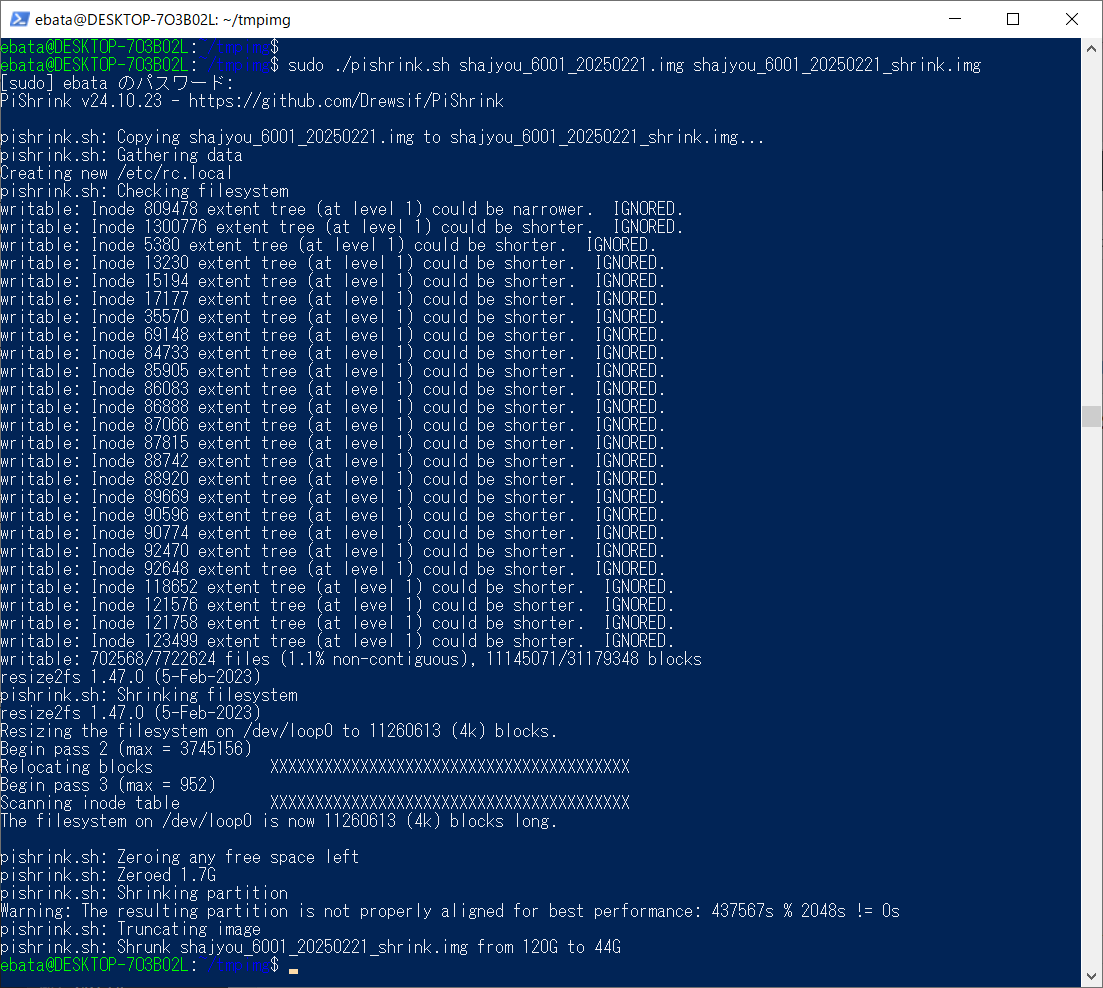

この紐付け作業のために、私は弊社のシステム部門の方を1時間以上拘束し、マンツーマンのテレビ会議で説明を受けながら操作を行いました。

To complete this linking process, I spent over an hour with a system department colleague in a one-on-one video call, receiving instructions step-by-step.

ちなみに、私は現役のシステムエンジニアですよ?

Just so you know—I’m a current, active system engineer.

そんな私が、機密情報を扱うシステム部門の人とタッグを組まなければ「紐付け」が完了しないシステムって、一体何なの?

If I have to team up with someone who manages confidential data to complete this process, what kind of system would that be?

そして今日は、その「紐付け」後、最初の運用日です。

And today is the first day I’m using the system post-linkage.

―― この紐付け、絶対に失敗している。そして私は大声で叫びながら、窓口やコールセンターに助けを求めるが、誰一人としてロクな回答ができず、キャンセルもできないまま、新幹線の発車時刻が過ぎていく……

—I had foreseen the worst: the link fails, I scream at the counter and call centers, no one can help, I can't cancel, and the train departs without me.

そういう最悪の未来を予知したがゆえに、私は「1時間半前の新横浜駅到着」を選んだのです。

That foresight is precisely why I arrived at Shin-Yokohama Station 90 minutes early.

だから、自動改札機から座席案内のタグが無事に出てきたとき、私は泣きそうになるくらい嬉しかったのです。

So when the seat tag came out of the automatic gate, I was on the verge of tears with joy.

-----

システムエンジニアとして、いま私の社会システムへの信頼度は、最大値を振り切ってマイナスに突入しています。

As a system engineer, my trust in our societal systems is currently off the scale, in the negative direction.

現在の私の唯一の希望は、生成AIによる「窓口システム」です。

My only hope now lies in AI-generated front-desk systems.

電話のたらい回しが、生成AIによって完全にワンストップで処理されるなら、

If generative AI can eliminate phone-based runarounds and offer accurate one-stop service,

―― もう、人間なんぞ消えてなくなってもいい

—Then let humanity vanish already.

と、私は言い切ります。

I say that without hesitation.