エクスプローラで、ファイルをコピーする場合、同じファイル名の場合には時刻が新しい場合のみ上書きしたいですがどうすれば良いですか

ChatGPT

ChatGPT

Windowsエクスプローラでファイルをコピーする際、同じファイル名の場合は時刻が新しい場合のみ上書きするという機能は標準では提供されていません。しかし、以下の方法でこの操作を実現できます。

方法1: コマンドプロンプトでrobocopyを使用

Windowsにはrobocopyという強力なコマンドラインツールがあり、これを使用してファイルのコピーを行うと、指定した条件に基づいてファイルを上書きできます。

以下の手順で行います。

コマンドプロンプトを管理者権限で開く

以下のrobocopyコマンドを実行

cmd

コードをコピーする

robocopy "コピー元フォルダのパス" "コピー先フォルダのパス" /XO

ここで、/XOオプションは古いファイルを除外します。これにより、コピー元フォルダのファイルがコピー先フォルダのファイルより新しい場合にのみ上書きされます。

例

コピー元フォルダがC:\source、コピー先フォルダがD:\destinationの場合、次のように入力します。

cmd

コードをコピーする

robocopy "C:\source" "D:\destination" /XO

cmd.exeを管理者モードで立ち上げ

C:\WINDOWS\system32>robocopy "f:\しゅらばしゅう" "\\192.168.0.23\ynu-share\しゅらばしゅう_フルバックアップ" /XO /E /Z

C:\WINDOWS\system32>robocopy "\\192.168.0.10\usb_mount" "\\192.168.0.23\ynu-share\usb_mount_フルバックアップ" /XO /E /Z

C:\WINDOWS\system32>robocopy "g:home\ebata\tomioka3B\src" "\\192.168.0.9\share\tomioka3B\src" /XO /E /Z

C:\WINDOWS\system32>robocopy "g:home\ebata\hakata" "\\192.168.0.9\share\hakata" /XO /E /Z

======

robocopy "f:\しゅらばしゅう" "\\192.168.0.23\ynu-share\しゅらばしゅう_フルバックアップ" /XO /E /Z

robocopy "\\192.168.0.10\usb_mount" "\\192.168.0.23\ynu-share\usb_mount_フルバックアップ" /XO /E /Z

robocopy "g:home\ebata\tomioka3B\src" "\\192.168.0.9\share\tomioka3B\src" /XO /E /Z

robocopy "g:home\ebata\hakata" "\\192.168.0.9\share\hakata" /XO /E /Z

echo

======

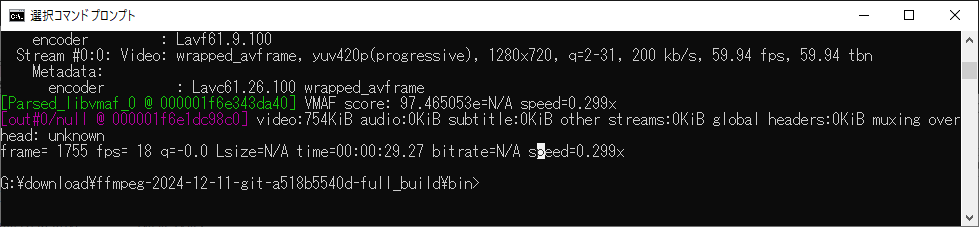

-------------------------------------------------------------------------------

ROBOCOPY :: Windows の堅牢性の高いファイル コピー

-------------------------------------------------------------------------------

開始: 2024年6月23日 10:23:39

コピー元 : G:\home\ebata\tomioka3B\src\

コピー先 : \\192.168.0.9\share\tomioka3B\src\

ファイル: *.*

オプション: *.* /S /E /DCOPY:DA /COPY:DAT /Z /XO /R:1000000 /W:30

------------------------------------------------------------------------------

4 G:\home\ebata\tomioka3B\src\

2 G:\home\ebata\tomioka3B\src\.vscode\

20 G:\home\ebata\tomioka3B\src\Agent\

4 G:\home\ebata\tomioka3B\src\Agent\ldarp\

2 G:\home\ebata\tomioka3B\src\Agent\old\

14 G:\home\ebata\tomioka3B\src\Agent - kese09161446\

2 G:\home\ebata\tomioka3B\src\Agent - kese09161446\ldarp\

2 G:\home\ebata\tomioka3B\src\Agent - kese09161446\old\

14 G:\home\ebata\tomioka3B\src\Agent-kese-09161400\

2 G:\home\ebata\tomioka3B\src\Agent-kese-09161400\ldarp\

2 G:\home\ebata\tomioka3B\src\Agent-kese-09161400\old\

1 G:\home\ebata\tomioka3B\src\agent_db\

14 G:\home\ebata\tomioka3B\src\CartはAgentに併合\

1 G:\home\ebata\tomioka3B\src\CartはAgentに併合\ldarp\

2 G:\home\ebata\tomioka3B\src\CartはAgentに併合\old\

1 G:\home\ebata\tomioka3B\src\inc\

5 G:\home\ebata\tomioka3B\src\Join\

1 G:\home\ebata\tomioka3B\src\Join\ldarp\

3 G:\home\ebata\tomioka3B\src\ldarp\

4 G:\home\ebata\tomioka3B\src\old\

22 G:\home\ebata\tomioka3B\src\old\doc\

253 G:\home\ebata\tomioka3B\src\others\

1 G:\home\ebata\tomioka3B\src\others\.vscode\

8 G:\home\ebata\tomioka3B\src\others\chart\

105 G:\home\ebata\tomioka3B\src\others\csvファイルのバックアップ\

1 G:\home\ebata\tomioka3B\src\others\main49\

1 G:\home\ebata\tomioka3B\src\others\main50\

8 G:\home\ebata\tomioka3B\src\PrumeMobile\

10 G:\home\ebata\tomioka3B\src\PrumeMobile\chart\

9 G:\home\ebata\tomioka3B\src\PrumeMobile\chart2\

8 G:\home\ebata\tomioka3B\src\PrumeMobile\old\

12 G:\home\ebata\tomioka3B\src\PrumeMobile\static\

25 G:\home\ebata\tomioka3B\src\trip_cluster\

100% 新しいファイル 105 #robocopy#

100% 新しい 7540 main.go

12 G:\home\ebata\tomioka3B\src\trip_cluster\bic\

100% 新しいファイル 858 plot_cluster7.gnuplot

4 G:\home\ebata\tomioka3B\src\trip_cluster\bus\

100% 新しいファイル 357 plot_cluster2.gnuplot

100% 新しいファイル 858 plot_cluster2.gnuplot~

56 G:\home\ebata\tomioka3B\src\trip_cluster\data(最初に手動で作成)\

9 G:\home\ebata\tomioka3B\src\trip_cluster\walk\

100% 新しいファイル 775 plot_cluster7.gnuplot

100% 新しいファイル 858 plot_cluster7.gnuplot~

2001 G:\home\ebata\tomioka3B\src\trip_normalization\

100% 新しい 4466 main.go

100% 新しいファイル 3678 main.go~

73 G:\home\ebata\tomioka3B\src\trip_test\

75 G:\home\ebata\tomioka3B\src\trip_test_tomioka2018\

100% 新しい 23276 main.go

100% 新しいファイル 124 robocopy

0 G:\home\ebata\tomioka3B\src\trip_test_tomioka2018\main copy.go(5\

75 G:\home\ebata\tomioka3B\src\trip_test_tomioka2018_harugakkai\

6 G:\home\ebata\tomioka3B\src\trip_test_tomioka2018_harugakkai\others\

4 G:\home\ebata\tomioka3B\src\trip_tomioka2018\

4 G:\home\ebata\tomioka3B\src\trip_tomioka2018\others\

100% 新しいファイル 587 dummy.txt

100% 新しいファイル 58 dummy.txt~

100% 新しい 3272 main.go

新しいディレクトリ 4 G:\home\ebata\tomioka3B\src\trip_tomioka2018_harugakkai\

100% 新しいファイル 162161 agent_od_test.csv

100% 新しいファイル 9022 libdarp.go

100% 新しいファイル 15470 main.go

100% 新しいファイル 18255 tools.go

新しいディレクトリ 4 G:\home\ebata\tomioka3B\src\trip_tomioka2018_harugakkai\others\

100% 新しいファイル 162161 agent_od_test.csv

100% 新しいファイル 587 dummy.txt

100% 新しいファイル 58 dummy.txt~

100% 新しいファイル 3272 main.go

------------------------------------------------------------------------------

合計 コピー済み スキップ 不一致 失敗 Extras

ディレクトリ: 47 2 45 0 0 0

ファイル: 2890 22 2868 0 0 0

バイト: 35.39 m 408.0 k 34.99 m 0 0 0

時刻: 0:00:02 0:00:01 0:00:00 0:00:01

速度: 278161 バイト/秒

速度: 15.916 MB/分

終了: 2024年6月23日 10:23:42