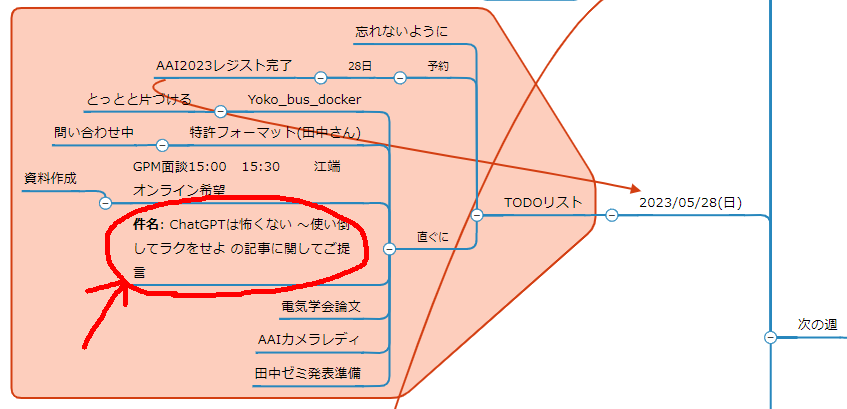

件名: ChatGPTは怖くない ~使い倒してラクをせよ の記事に関してご提言

この週末2日間かけるつもりだった「カメラレディ」を、"grammarly"のおかげもありまして、1日で投稿し、学会へのレジストレーションを終えました。

週末エンジニアの、この貴重な一日を何に使うか ――

うん、これに使わせて頂こう、と決めました。

今回、以下のコラムを寄稿致しました。

ChatGPTは怖くない ~使い倒してラクをせよhttps://t.co/tCHAfKsu6r

— EE Times Japan編集部 (@eetimes_jp) May 15, 2023

で、読者の方(Sさん)から、以下のメールを頂きました。

江端智一 様

初めてメールさせていただきます。"S"と申します。

いつも記事・日記ともに楽しく拝見させていただいております。

今回:ChatGPTの記事で一点気になるところがあり、ご連絡させていただきました。6ページ目以降、「ChatGPTの本体は、ニューラルネットワークです。」とまとめている点は少し実体と異なっている気がいたします。

GPT-3の主要な要素Transformerにおいては、ニューラルネットではなく、Attention機構がその主役です。

(2層のフィードフォワードのニューラルネットは使われていますが、CNNやRNNは使われていないのが特長とのことです。)・参考① オミータ氏の記事

https://qiita.com/omiita/items/07e69aef6c156d23c538・参考② 杉山聡氏 「分析モデル入門」

(執筆者の杉山聡氏がYoutubeでも解説しています

https://www.youtube.com/watch?v=50XvMaWhiTY&t=498s)特に②の受け売りですと、Attention機構は内積を用いた類似度計算が肝とのことです。

ですので、「ChatGPTの本体は、内積を用いた類似度計算です。」という方がしっくりきます。私自身ソフトウェア(組込)系ではありますがデータサイエンス・機械学習等に詳しいわけではないので、

参考情報として受け取っていただければと思います。以上、ご確認いただけましたら幸いです。

いつもながら、大変ありがたいことです。私の記事は読者の皆様によって支えられております。引き続き、よろしくお願い致します。

で、改めて確認してみましたが、ご指摘は正しいと確認いたしました。

ニューラルネットワーク(フィードフォワード型と、SoftMax Function)も使っていますが、どちらかというと、「ニューラルネットワークの学習で汗をかく」というよりは、「(文章コーパスのデータを使った?)統計処理&類似度の確率計算をする」という処理が、全体のほぼ9割くらい、という感じでした。

【本日の人気記事】Over the AI ―― AIの向こう側に(16):モノマネする人工知能 ~ 自動翻訳を支える影の立役者 https://t.co/E8N2pOflUM pic.twitter.com/qSIyVHX21I

— EE Times Japan編集部 (@eetimes_jp) October 30, 2017

上記のコラムのp.7に記載した「対訳コーパスとEBMT/SMTの関係」の図のイメージに近い感じ、と思っています。

わざわざニューラルネットワークで非線形関係を学ばせまでもなく「Attention機構の内積を用いた類似度計算」で、バッチリ行けるぜ ―― という風に、(私は)理解しました。

うん、ニューラルネットワークなんぞ、使わずにすめばそれに越したことはありません(私は、第2次AIブームで、ニューラルネットワークで痛い思いをしています)。

ちなみに、私、杉山聡氏のYoutubeには、たびたびお世話になっております。今回も、紹介して頂いた映像で勉強致しました。

今回私が驚いたのは、このビデオクリップの最後の方に出てくる、Multi-Head Attention の concatです。このビデオではよく分からなかったのですが、ベクトルXに対して、回転変換(でいいんのかな?)する行列の内積を取る、というのは、まさに類似度計算です。

ただ、今、私が分かっていないのは、行列の回転角をどうやって決めているのだろう、ということです。これってGivenで与えられる値なのか、あるいは、フレーズ(から求められたベクトル)毎に、何かのアルゴルズムを使って回転角θを求めているのか ―― あるいは、私が、全く的外れなことを言っているのか ―― が、まだ分かっていません。

ただ、この技術は、様々な分野(ゲームなど)にも使われているとの話を鑑みれば、「ニューラルネットワーク学習の悪夢」なしに、過去の膨大な情報と行列式だけで、非線形の関連の出力を得られるということになります。

これはAI技術にとって、大きな福音です。アホみたいに膨大な学習プロセスなしに、非線形関係が求められるのであれば ―― 少なくとも、学習計算にかかるコンピュータの電気料金の節約の効果は計り知れません。

今後も助けて頂く予定としております。

引き続きよろしくお願い申し上げます。

江端智一