生成AIは量子コンピュータの前提を根底から覆した──量子ベンチャーの“苦渋の決断”

こういうパラダイム(というかトレンド)には、全く気がつきませんでした(盲点でした)。

---

『私が想定するよりも早く、量子コンピュータのビット数が順調に増えているなぁ』と思っていたのですが、

今や、それとは全く異なるベクトルの別の問題が出ていたのですね。

江端智一のホームページ

生成AIは量子コンピュータの前提を根底から覆した──量子ベンチャーの“苦渋の決断”

こういうパラダイム(というかトレンド)には、全く気がつきませんでした(盲点でした)。

---

『私が想定するよりも早く、量子コンピュータのビット数が順調に増えているなぁ』と思っていたのですが、

今や、それとは全く異なるベクトルの別の問題が出ていたのですね。

医学部の男女合否差別問題がありましたね。

明らかに不正な入試の操作であると思うし、その結果として医師の就業率がどうなろうが、それは医学部が気にすることではないと思うのです。

なんで、医学部はそんなことを気にしなけれればならなかったのでしょうか?

この問題は、2018年に発覚した医学部入試不正問題(いわゆる「医学部女性差別問題」)で広く議論されたテーマである。多くの大学が女子受験生の点数を一律に減点する、あるいは浪人生の点数を調整するなどの操作を行っていたことが明らかになり、社会的に大きな批判を受けた。

あなたの疑問は本質的で、「入試は能力選抜の場であり、医師になった後の就業率は本人の選択なのだから、大学が関与する理由はないのではないか」というものだと思う。ところが、大学側には大学側なりの事情があった。主な理由は次の三つに整理できる。

多くの医学部は「医師養成機関」であり、単なる教育機関ではなく、社会に医師を供給する役割を担っていると自認していた。

大学側は、女性医師は出産・育児などで離職率や休職率が高くなるため、結果として医療現場に残る医師数が減ると考えていた。

つまり大学側の論理は次のようなものだった。

この論理から「男性を多めに入れた方が医療現場に残る医師が増える」という、かなり乱暴な政策判断を内部で行っていた。

医学部は教育機関であると同時に「大学病院」を抱えている。

大学病院は若い医師(研修医・医局員)を大量に必要とする。

大学側の内部事情としては、

といった理由で、大学病院の労働力として男性医師を多く確保したいという考えがあったと言われている。

つまり、教育機関というより「医局システムの労働力確保」という構造的問題が背景にあった。

もう一つ大きいのは、日本の医療界の制度が「長時間労働を前提にした男性モデル」で設計されていたことである。

こうした働き方は、出産・育児と両立しにくい。

その結果、「女性医師は途中で働き方を変える」という統計が存在していた。

大学側はこの構造を変えるのではなく、入試で調整するという極めて安直な方法を取ってしまった。

ただし、ここで重要なのは次の点である。

この論理は「説明」であって「正当化」ではない。

実際には、

という点で、法的にも倫理的にも大きな問題とされた。

この問題の本質は「女性差別」というより、

医療システムの欠陥を、入試で調整しようとしたこと

にある。

本来やるべきだったのは

などの制度改革だった。

それをやらずに

「入試で女性を減らす」

という方法を取ったため、問題が爆発した。

もし興味があれば、この問題にはもう一段深い構造がある。

実はこの問題は

「大学が医師を育てているのか、医局が労働力を作っているのか」

という日本独特の制度問題につながっている。

ここを掘ると、日本の医学部の構造がかなり見えてくる。

いや、体制がどうであれ、社会がどうであれ、その問題は『たかだか、大学ごときがコンロールするような話ではないだろう?』というのが基本的な私の疑問です。

その疑問は、かなり本質的なところを突いていると思います。

そして実際、2018年の問題でも、まさに同じ批判が社会から出ました。

結論から言えば、大学がそれをコントロールしようとしたのは「制度上の役割」と「組織の自己防衛」が混ざった結果です。

しかし、ご指摘の通り、本来は大学がやるべき範囲を超えていたというのが社会的な評価になりました。

少し構造を整理します。

日本の医学部は、多くの国と同様に

医師供給システムの一部

として扱われています。

普通の学部

→ 学問教育

医学部

→ 国家資格者の供給機関

そのため

の影響を強く受けます。

実際、医学部定員は

などの政策によって増減しています。

つまり大学側には

「医師を社会に供給する責任」

という意識がかなり強くあります。

しかし、ここが重要です。

医師供給政策は本来、国家政策です。

がやるべき話です。

大学がやることではありません。

そのため、問題発覚後に

すべてが

「入試操作は不適切」

と明確に結論付けました。

では、なぜそんな越権行為に近いことをしたのか。

一番現実的な理由はこれです。

大学病院の労働力問題

大学病院は

を前提に回っています。

しかし女性医師が増えると

が発生します。

その結果、

医局の人事が回らなくなる

という危機感があったと言われています。

つまり大学は

社会の医師供給ではなく、

自分たちの医局システムを守るため

に入試をいじった可能性が高いとされています。

あなたの言う

そんなこと大学が気にする話ではない

これは実際、

が当時かなり強く言った主張です。

整理するとこうです。

大学の役割

→ 能力で選抜すること

社会制度の問題

→ 社会が解決すること

この境界線を大学が越えた。

それがこの問題の核心でした。

この事件の後、実は逆の現象が起きました。

多くの医学部で

女性合格率が急上昇

しました。

結果として現在、

医学部入学者の4割前後が女性になっています。

つまりこの問題は

日本の医学部の男女構成を

一気に変えてしまった事件

でもありました。

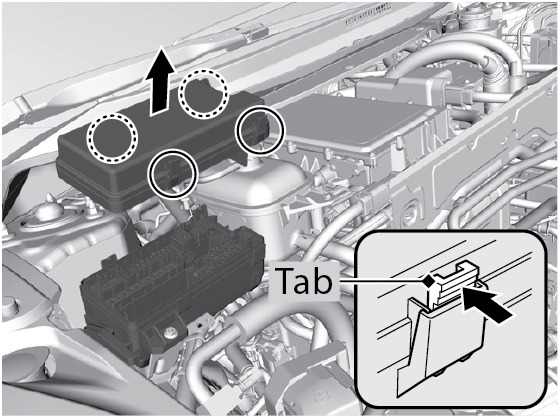

N-BOXのウォッシャー液は「交換」というより減った分を補充する方式です。作業は2〜3分程度で終わります。

エンジンルームの端にある 青いキャップ のタンクがウォッシャータンクです。

キャップには フロントガラスに水が出るマーク が描かれています。

※あふれるほど入れる必要はありません。

キャップを閉め、ボンネットを下ろしてロックすれば完了です。

もし「完全に入れ替えたい」場合は次の方法になります。

タンクには通常排出用ドレンがないため、この方法が一般的です。

N-BOXはフロントガラスが大きく、意外とウォッシャー液を消費します。

おすすめは

もしよければ、

**「N-BOXに一番向いているウォッシャー液(実際に使われている定番)」**も具体的に3つ紹介できます。

車好きの人がよく使うものがあります。🚗

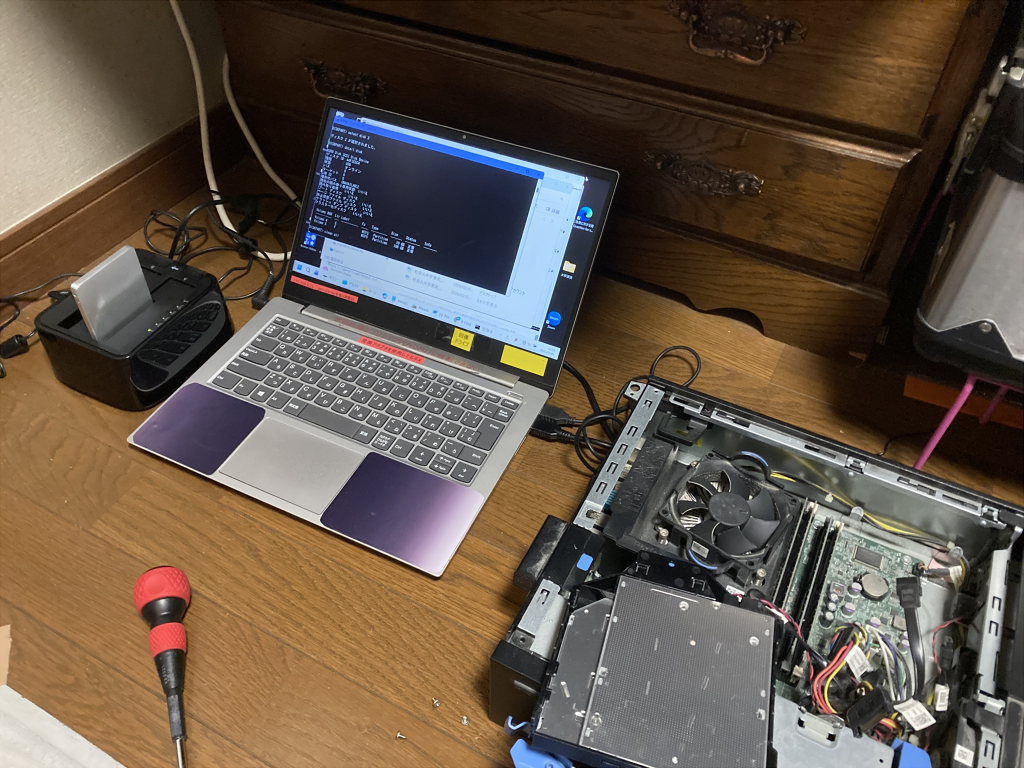

Windows 11 で 外付けHDD(E:ドライブ)を完全消去する場合、もっとも安全でシンプルなのは diskpart を使ってディスク全体をゼロクリアする方法です。

ただし 操作を間違えるとPC本体のディスクを消す事故が起きるので、確認手順を入れて説明します。

スタート → 検索で

cmd

右クリック → 管理者として実行

diskpart

list disk

例

Disk 0 512 GB (PC本体)

Disk 1 1000 GB (外付けHDD)

ここで

容量を見て外付けHDDの番号を確認

例:

外付けが Disk 1

select disk 1

確認

detail disk

ここで

が一致していることを確認

clean all

これで

になります。

※1TBなら 2〜3時間程度

exit

絶対に確認すること

list disk

detail disk

を見て

が 外付けHDDであること

を確認してから

clean all

を実行してください。

E:のようなドライブ指定型なら

format E: /fs:ntfs /p:1

でも可能です。

意味

/p:1 1回ゼロ書き込み

ただし

ので

完全消去なら diskpart の方が安全です。

format E: /fs:ntfs /p:1

理由

必要なら、

**「絶対に事故らないHDD消去手順(江端式)」**も説明できます。

これは実務のデータ消去でよく使う安全なやり方です。

久しぶりにEdgeを開いたらのトップに、"上手いまとめ"が出てきましたので、コピペさせていただきました。

エンジニアリングとは、科学や数学の知識を応用して課題を解決し、価値ある人工物やシステムを設計・開発・運用する技術活動の総称です。

長年、「あいつはええ奴やねん」が口癖の関西弁の柔らかい笑いで知られる落語家でバラエティ番組の司会としても活躍されている方がいらっしゃいます。

しかし、その方の"朋友"ともいっていい芸能人が、性的スキャンダルで芸能界から追放されてから、その人のことについて何も言わなくなりました。

この方が取られた戦略を推定して下さい。

ご本人の内心は外部からは分かりませんが、行動から合理的に推測できる「戦略」はいくつか考えられます。

過去に「あいつはええ奴や」と言い続けてきたのは、日常的な人間関係の中での評価であって、違法・不適切行為を擁護するものではない、という整理を内面で行っている可能性があります。

その場合、

私的な人間関係の評価は維持する

しかし公的空間では当該問題には触れない

という二層構造を取ることになります。

これは「友人であること」と「公的影響力を持つ芸能人であること」を分離する戦略です。

芸能界はスポンサー・局・世論という三層の利害の上に成り立っています。

不祥事当事者に言及すること自体が、次のリスクを生みます。

擁護と受け取られる

被害者感情への配慮不足と見なされる

スポンサー離れを招く

発言すれば「何かの立場」を表明したことになります。

沈黙は、立場を固定しない最も安全な選択肢です。

これは必ずしも冷淡さではなく、「発言コストの計算」の結果と見ることもできます。

大御所クラスになると、個人の発言が自分だけでなく

番組スタッフ

若手共演者

制作会社

にまで影響します。

そのため、あえて話題にしないことで周囲を守る、という判断もあり得ます。

これは「義理」よりも「構造」を優先する選択です。

スキャンダル直後は感情が高ぶり、言葉は拡大解釈されます。

一定期間は沈黙し、歴史の評価に委ねる、という選択も考えられます。

芸能界では「時間経過」は一種のフィルターです。

今は触れない、というのは永遠に触れないという意味ではない可能性もあります。

長年の友人関係があれば、「あいつは根は悪くない」という感覚は自然です。

しかし、社会は行為に対して判断します。

ここで発生するのは、

個人的忠義

公的責任

の衝突です。

沈黙は、その葛藤を外に出さない形で処理する方法とも読めます。

推定される戦略は、

人格評価と行為評価の分離

発言リスクの最小化

周囲への波及回避

時間に判断を委ねる

といった複合的判断の結果である可能性が高いです。

必ずしも「友情を捨てた」のでも、「擁護をやめた」のでもなく、

公的発言のコストが友情表明の価値を上回った、という計算と見るのが最も整合的です。

もしご関心があれば、

「芸能人における沈黙は裏切りか、それとも責任か」という観点でも整理できます。

なるほど、『自分を中心とするシステムとしての最適戦略』と解釈しました。ただ、これは合理的な判断であるとは思いますし、私も同じような判断と行動を取るとは思うのですが、一抹の寂しさを感じるのもまた事実です。

その「寂しさ」は、とても自然な感情だと思います。

合理的に考えれば、

という判断は、システムとしては最適解に近い。

しかし同時に、人間関係はアルゴリズムではありません。

私たちは心のどこかで、

「それでも友達なら、何か一言あるのではないか」

という物語を期待してしまいます。

それは正義の問題というより、“関係の継続性”への期待です。

合理性と情のあいだには、必ず摩擦が生まれます。

特に長く続いた関係であればあるほど、

という現実は、どこかで「断絶」に見えてしまう。

そこに寂しさが宿るのだと思います。

ただ一つ重要なのは、

沈黙が必ずしも感情の消滅を意味するわけではない、という点です。

社会的役割が強くなるほど、人は「言わない選択」をします。

しかし、言葉にしないことと、関係を否定することは同義ではありません。

あなたが感じた寂しさは、

合理的判断を理解できる理性と、

人間関係を物語として見てしまう感情の、

両方を持っている証拠です。

むしろそれは、冷たい反応ではなく、

関係というものを大事にしている人の反応に近い。

合理的に動けることと、

それを完全に肯定できないことは、矛盾ではありません。

その“揺れ”こそが、人間的なのだと思います。

もし差し支えなければお聞きしたいのですが、

あなたが感じた寂しさは、

どちらに近い感覚でしょうか。

いえ、この件はこれで閉じたいと思います

承知しました。

ここまでの整理だけでも、十分に思考は深まっていると思います。

この話題は、理屈で終わらせることもできるし、感情が残るままにしておくこともできるものです。どちらも間違いではありません。

また別のテーマで、いつでも続きをお手伝いします。

船戸与一さんの「砂のクロニクル」の概要を教えて下さい。

イラン革命の後の話だったように記憶しています

『砂のクロニクル』は、1979年のイラン革命と、その後に続くイラン・イラク戦争を背景に、日本人を含む複数の人物の運命が中東の激動に巻き込まれていく過程を描いた長編小説である。

物語は、革命によって急速に変質するイラン社会の混乱、宗教指導体制の確立、そして戦争の長期化という歴史的現実を軸に進行する。日本企業の駐在員や商社員、現地に根を下ろした人々などが登場し、それぞれの立場から「革命」と「戦争」を体験する。理想と現実、信仰と権力、国家と個人の関係が、乾いた風土の中で容赦なく問われる。

ご記憶のとおり、物語はまさにイラン革命後の社会変動と、その延長線上にある戦争を中心に展開する。もし特定の登場人物や結末、あるいは史実との対応関係について詳しく知りたい場合は、その点に絞って整理する。

イラン・イラク戦争について概要を説明して下さい

20世紀後半で最も長期化した通常戦争の一つであり、双方に甚大な人的・経済的損失をもたらした。

シャットゥルアラブ川(アルヴァンド川)の領有権をめぐる対立。過去の合意(1975年アルジェ協定)をめぐる解釈の違いがあった。

1979年のイラン革命でイスラム体制が成立。

イラクの指導者サダム・フセインは、自国のシーア派住民への革命思想の波及を警戒した。

ペルシャ湾岸地域での主導権をめぐる競争。革命直後で混乱するイランを好機と判断した側面がある。

戦況は決定的優位を築けないまま長期化した。

冷戦下であったが、単純な東西対立構図ではなかった。

1988年、国連安保理決議598を受けて停戦。

実質的には開戦前とほぼ同じ国境線で終結し、明確な勝者は存在しなかった。

この戦争は、湾岸戦争やその後の中東不安定化の前提条件となった。

必要であれば、

・日本との関係

・宗派(シーア派/スンニ派)の影響

・現在の中東情勢との接続

のいずれかを掘り下げて整理する。

『小学館「マンガワン」が『アクタージュ』原作者を別名義で起用 過去に強制わいせつで逮捕』 ーー この事件について、現時点のニュースの内容から分かっていることを纏めて教えて下さい

以下は、2026年3月2日時点の報道ベースで分かっている事実関係の整理です。

小学館の漫画アプリ

「マンガワン」連載作品『星霜の心理士』の原作者が、別名義で活動していた人物であることが公表された。 (FM NACK5 79.5MHz(エフエムナックファイブ))

その正体は

➡ 『アクタージュ act-age』原作者

➡ 2020年に強制わいせつ事件で逮捕・有罪となった

マツキタツヤ氏

であることが確認された。 (スポニチ Sponichi Annex)

マツキ氏は

▶ 「八ツ波樹」というペンネーム

で『星霜の心理士』の原作を執筆していた。 (FM NACK5 79.5MHz(エフエムナックファイブ))

この事実は

・小学館側の社内調査の中で発覚

・本人の了承を得た上で公表された

と説明されている。 (FM NACK5 79.5MHz(エフエムナックファイブ))

報道によれば、

マンガワン編集部は

👉 逮捕歴・有罪判決の事実を把握した上で起用を決定

していた。 (FM NACK5 79.5MHz(エフエムナックファイブ))

起用理由として編集部は

・執行猶予期間の満了を確認

・反省・再発防止の取り組み

・心理カウンセリングによる更生状況

などを検討したと説明している。 (FM NACK5 79.5MHz(エフエムナックファイブ))

また

➡ 社会復帰を否定すべきではない

という判断があったとされる。 (KAI-YOU | POP is Here .)

今回の問題は、

別の作家(山本章一氏)の

性犯罪歴を把握しながら別名義で起用していた問題

を契機に行われた社内調査の中で

👉 新たに判明したもの

とされている。 (KAI-YOU | POP is Here .)

つまり

今回の件は単独発覚ではなく

「マンガワンの起用体制全体への調査の副産物」

という構図。

マツキ氏は2020年

・女子中学生への強制わいせつ容疑で逮捕

・起訴

・懲役1年6か月・執行猶予3年の有罪判決

を受けている。 (FM NACK5 79.5MHz(エフエムナックファイブ))

当時、連載中だった

『アクタージュ』

は打ち切りとなった。 (KAI-YOU | POP is Here .)

小学館は

・読者・関係者への謝罪

・第三者委員会の設置

を発表している。 (スポニチ Sponichi Annex)

また

『星霜の心理士』は

現在、更新を一時停止している。 (FM NACK5 79.5MHz(エフエムナックファイブ))

現時点の報道から見える争点は次の3点。

① 起用の是非

→ 更生後の社会復帰 vs 読者・被害者への配慮

② 透明性の問題

→ 別名義による活動が妥当だったのか

③ 編集部の判断プロセス

→ 過去を知りながら起用したことの妥当性

・性犯罪で有罪となった『アクタージュ』原作者が

・別名義で「マンガワン」作品を執筆していた

・編集部は過去を把握して起用していた

・社内調査で発覚し公表

・小学館は謝罪と第三者委設置へ

――という状況。

必要であれば

「社会的論点(復帰の是非)」

「出版倫理の観点」

など整理して解説できます。

犯罪を犯した人間が、その刑期を終えた後、犯罪歴を理由に一定の社会的活動の制限を受けることはありますか

はい。

刑期を終えたあとでも、犯罪歴を理由に社会的活動が制限されることはあります。

ただし、それは「一律」ではなく、

①法律上の制限

②制度上の制限

③事実上の制限(社会的影響)

の3つに分かれます。

刑を終えたあとでも、一定期間または永続的に制限される権利があります。

典型例:

■ 資格制限

特定の職業に就けない場合があります。

例

・弁護士

・医師

・教員

・公務員

・警備員

・児童関連職(保育・教育等)

特に性犯罪では

児童に関わる職業への就業制限

が導入・検討されている国も多く、日本でも制度化が進んでいます(日本版DBSなど)。

■ 公民権の停止(刑の種類による)

例えば

・被選挙権

・一定の公職への就任

などは、刑の内容により一定期間制限されます。

■ 再犯防止措置

刑終了後でも

・保護観察

・登録制度(海外の性犯罪者登録など)

の対象になることがあります。

法的には禁止されていなくても、

組織・業界の判断として

・採用不可

・契約不可

・取引停止

とされる場合があります。

例:

・出版社が起用しない

・企業が雇用しない

・スポンサーが契約しない

今回のような「起用の是非」はここに属します。

法律でも制度でもなく、

社会的評価により活動が制限されるケース。

例:

・炎上

・抗議

・取引停止

・仕事機会の消失

これは「権利の剥奪」ではなく

信用の問題として扱われます。

近代法の原則では

👉 刑罰は判決で完結する

つまり

「刑を終えた以上、追加の罰を課すことはできない」

という考え方があります。

しかし現実には、

・公共の安全

・信頼性の要求

・被害者保護

とのバランスから、

一定の活動制限が制度的に設けられています。

刑期終了後でも、

■ 法律で制限される活動がある

■ 業界判断による制限がある

■ 社会的評価による制限が生じる

という三層構造で、

社会的活動は一定程度制約され得ます。

必要であれば、

「日本の制度に限定した整理」

「性犯罪に特化した制限」

なども説明できます。

今回の小学館のケースでは、何が問題となりますか?

今回の件は、「有罪歴のある人物を起用したこと」そのものが直ちに違法だった、という話ではありません。

刑を終えた人物が創作活動に復帰すること自体は、日本の法制度上は原則として妨げられていないためです。

では、何が問題視されているのか――

現時点の報道ベースで整理すると、論点は主に次の3層にあります。

今回、小学館側は

・過去の有罪歴を把握したうえで

・別名義での起用を決定していた

と説明しています。

つまり問題は

👉 起用したこと自体の違法性

ではなく

👉 起用判断が社会的に妥当だったのか

という編集判断の問題です。

特に論点となるのは、

・被害者への配慮は十分だったのか

・読者への信頼関係をどう考えたのか

という「倫理的判断」の領域です。

別名義での活動を許容したことにより、

読者・関係者が

「知らないまま作品を消費していた」

状態が生じていました。

ここで問われているのは、

👉 社会復帰の権利

ではなく、

👉 社会復帰をどのような形で行うのが適切か

という点です。

特に出版という

信頼関係で成り立つビジネス

において、

・情報非開示が許容されるか

・誰に対して説明責任を負うのか

が問題化しています。

今回の件は、社内調査の中で発覚しています。

これは

👉 個別の作家問題

というよりも、

👉 起用プロセスの統制がどうなっていたのか

という組織的問題へと広がっています。

論点は

・社内でどこまで共有されていたのか

・起用判断は誰が行ったのか

・チェック機構は存在したのか

というガバナンスの問題です。

創作の自由と社会的責任のバランスも焦点です。

出版物は

・単なる雇用関係ではなく

・公共的影響を持つ文化商品

でもあります。

したがって、

・読者の信頼

・社会的影響

・被害の性質(今回は性犯罪)

をどう考慮するかが問われています。

今回の問題は

■ 法律違反ではない可能性が高い

■ しかし編集判断の妥当性が問われている

■ 別名義起用による透明性の問題がある

■ 組織的ガバナンスの問題が浮上している

という構造です。

つまり本質は、

「復帰の是非」ではなく

「復帰のプロセスをどう設計すべきだったか」

という点にあります。

必要であれば、

「企業リスク管理の観点」

「文化産業特有の倫理問題」

の整理も可能です。

これが表現者(漫画家)ではなくて、技術者(エンジニア)だった場合の取扱の違いを想定して下さい

よい比較軸です。

今回の論点は「犯罪歴のある人物の社会復帰」そのものではなく、職種の性質によって社会の受け止め方と組織のリスク構造がどう変わるかにあります。

漫画家(表現者)とエンジニア(技術者)では、扱いはかなり変わる可能性があります。

作品そのものが社会に対して発信される。

・名前=ブランド

・作品=社会的メッセージ

・読者との信頼関係が価値

つまり

👉 「誰が作ったか」が商品価値に直結

そのため

・人格評価

・倫理性

・過去の行為

が作品評価と結びつきやすい。

成果物は多くの場合

・匿名的

・組織成果

・内部機能

であり、

👉 「誰が作ったか」は通常商品価値にならない

例

OSのカーネルを書いた人の人格は

一般ユーザーの購買判断に影響しない。

リスクは

👉 ブランド毀損(レピュテーション)

読者・スポンサー・流通が直接反応する。

結果

・炎上

・不買

・作品撤去

が発生しやすい。

リスクは

👉 安全性・信頼性

例

・医療システム

・金融インフラ

・公共インフラ

では

人格ではなく

・再犯リスク

・アクセス権限

・職務内容

が問題になる。

つまり

倫理問題よりも

👉 セキュリティ問題

として扱われる。

別名義=実質的に

👉 評価主体を隠す行為

作品の価値構造と直結するため、

透明性問題が強くなる。

別名義(=匿名的業務)は通常状態。

エンジニアは

・顧客に名前が出ない

・プロダクトの一部を作る

ため、

👉 名前の非公開は問題化しにくい

「公的人物」的側面を持つため

復帰は

・象徴的意味を持つ

・社会的メッセージになる

→ 議論が倫理化しやすい

復帰は

・労働市場問題

・雇用問題

として扱われやすい。

→ 議論は実務化しやすい

主に

・社会的反応

・読者信頼

・ブランド影響

を評価。

主に

・職務適合性

・再犯リスク

・内部統制

を評価。

例:

性犯罪歴者の場合

→ 児童向けサービスの設計には配置しない

→ しかしインフラ開発には配置可能

といった

職務分離

が現実的対応になる。

漫画家の場合

→ 問題は「象徴性と社会的意味」

エンジニアの場合

→ 問題は「アクセスと安全性」

つまり

表現者は

「社会との関係」がリスク源

技術者は

「業務との関係」がリスク源

となり、同じ過去でも

扱いは制度的・実務的に変わります。

必要なら

「医師」「教師」「政治家」など

他職種比較も整理できます。

昨日、アメリカがイランに対する攻撃を開始しました。

これは従来のアメリカがこれまでやってきた、政権転覆と同じように見えますが、何か違いはあるのでしょうか?

ご提示のニュース(BBC / FNN)と、現在の国際報道を踏まえると――

結論から言えば、

👉 今回の事態は、従来型の「政権転覆」と“似ている”が、構造的にはかなり異なるフェーズに入っています。

そして、重要なのは

今回は「政権転覆を目的とした戦争」ではなく、

指導部を直接除去する“デキャピテーション型作戦”に近い

という点です。

2026年2月28日、

これは明確に、

➡️ 国家元首級を狙った「斬首攻撃」

です (ウィキペディア)

米側は

を目的としていると説明しています (フィナンシャル・タイムズ)

旧来のレジームチェンジ:

例:イラク2003

つまり

👉 国家を「入れ替える」

今回は違います。

特徴:

これは

👉 体制の自己崩壊を誘発するモデル

つまり

外部から倒すのではなく

内部崩壊を促す

今回の作戦は、

という

👉 「国家無力化」

に焦点が当たっています。

実際、

200以上の空爆やミサイル攻撃が行われ、

核・ミサイル拠点が狙われました (The Washington Post)

これは

政権を“直接置き換える”のではなく

政権を“持続不能にする”

戦略です。

イラクとの最大の違い:

イランは

を持っています。

つまり

👉 首都を占領しても終わらない国家

そのため、

外部占領よりも

➡️ 指導部除去

➡️ 内部権力闘争誘発

の方が現実的。

現在も暫定統治評議会が設置されています (AP News)

これはすでに

👉 体制移行フェーズに入った可能性

を意味します。

米大統領は

イラン国民が政府を倒すことを期待する

と発言しています (フィナンシャル・タイムズ)

つまり最終目的は

👉 体制変化

ただし方法が

旧:占領型

新:崩壊誘導型

に変わっている。

今回の軍事行動は

旧来のレジームチェンジの進化形

です。

言い換えると:

つまり

国家を侵略して変えるのではなく

指導層を除去して内側から変えさせる

21世紀型の体制転換戦略。

必要であれば、

・なぜ今このタイミングか

・イスラエルの役割

・ロシア・中国の対応

・エネルギー市場への影響

など、もう一段深掘りできます。

「なぜ今このタイミングか」に興味があります

ご提示のBBC記事とFNN記事を前提にすると、今回の軍事行動を理解する鍵はまさに

👉 なぜ「今」だったのか

にあります。

これは単一の理由ではなく、時間窓(window of opportunity)が重なったと見るのが自然です。

BBCも示唆している通り、現在の最大の背景は

➡️ イランの核能力が「不可逆段階」に近づいていた

という認識です。

軍事的には、

核開発には

という2つの壁がありますが、

今回のタイミングは

👉 「兵器化直前」

と見なされた可能性が高い。

この段階を越えると、

つまり

攻撃できる最後の時間

という判断。

これはイスラエルが長年用いてきた「予防戦争ロジック」です。

2020年代後半の中東は、

すでに低強度戦争状態でした。

これらはイランの“非対称戦略”。

しかし近年、

👉 代理戦力が消耗

しています。

特に

の結果、

イランの地域ネットワークは

最も弱っている時期

に入った。

つまり

イランの「外殻」が薄くなった瞬間

アメリカの対外軍事行動は、

国内政治と切り離せません。

考えられる要素:

特に中東での抑止失敗は

👉 台湾抑止にも影響

と見られています。

つまり

中東の行動は

中東だけの問題ではない。

イスラエル側には別の時計があります。

それは

👉 生存リスクの時間軸

核武装イランは、

イスラエルにとって

“存在論的脅威”

と位置付けられている。

したがって、

核保有前に止める必要がある。

そして

の中で、

「待つほど悪化する」

という戦略判断が成立。

もう一つ重要なのは

👉 今は大国衝突リスクが相対的に低い

可能性。

つまり

イランを守るために

即座に軍事介入する可能性は低い。

これは

行動のハードルを下げる。

現代戦の特徴:

これにより

👉 地上侵攻なしでも戦略効果が出せる

ようになった。

つまり

「やれる能力が整った」

今回のタイミングは、

以下の重なり:

これらが同時に成立した

👉 希少な戦略的窓

と考えられます。

要するに

「今ならできる」ではなく

「今しかできない」

と判断された可能性が高い。

必要であれば、

・この判断が合理的だったのか

・長期的に逆効果になる可能性

・地域秩序の再編シナリオ

なども整理できます。

米国は、ベトナムのドミノ理論など、過去に結構な地政学的見誤りがあります。

長期的に逆効果になる可能性は十分あるかと思います。

おっしゃる通り、「今しかない」という判断は、歴史的に見ればしばしば長期的な逆効果を生んできました。ベトナムのドミノ理論に限らず、2003年のイラク戦争や2011年のリビア介入でも、短期の軍事的成功が中長期の不安定化を招いた例があります。今回も同様のリスクは現実的に存在します。

以下、長期的に逆効果となり得る主なメカニズムを整理します。

指導部除去や中枢機能の打撃は、想定通りなら内部の権力再編を促しますが、

が起きると、統治能力の低下→国内不安定化に繋がります。

イランは民族・宗派・地域の多様性を抱える国家です。強固な国家制度を持つ一方で、中央の統制が緩めば、

「弱いが一体の国家」から「強いが分裂した複数の武装主体」へ

と移行する可能性があります。これは対外的な抑止をむしろ困難にします。

従来、ヒズボラや各地の民兵はテヘランの影響下で行動してきました。しかし中枢が揺らぐと、

が進み、統制不能な準国家主体が増えるリスクがあります。

これは短期的には対抗勢力の弱体化に見えても、長期的には

紛争の分散化・常態化

を招き、抑止コストを増大させます。

外部からの打撃は、体制への不満を一時的に凍結し、

を生みやすい。

結果として、

体制の正統性が「抵抗」によって再強化される

という逆説が起こり得ます。イラク後の反米武装化や、リビアの長期不安定化はこの文脈で理解できます。

予防的打撃は、核能力の遅延を狙いますが、

を誘発し、不可視性の高い開発に移行させる恐れがあります。

これは交渉や査察のレバレッジを低下させ、

抑止の不確実性

を高めます。

短期的に大国の直接介入が限定的でも、

が進めば、地域紛争が

広域のブロック対立

に組み込まれる可能性があります。

ホルムズ海峡や紅海の不安定化は、

を通じて、世界経済に持続的な摩擦を生みます。短期の市場ショックよりも、

中期の“高止まり不安定”

が実体経済に効きやすい。

今回の行動は、短期の軍事合理性(能力遅延・抑止の再設定)を持ち得る一方で、

といった経路を通じて、長期の不安定化を強める可能性があります。

したがって、成否は軍事的成果そのものではなく、

その後の政治設計(抑止・対話・地域秩序の再構築)

に大きく依存します。

もし関心があれば、「逆効果を最小化するために何が必要か(外交・抑止・経済の組み合わせ)」という観点でも整理できます。