現在、私は、大学の先生にお願いされて、イベント出席用の管理システムを設計しています。

Currently, I am designing a management system for event attendance at the request of a university professor.

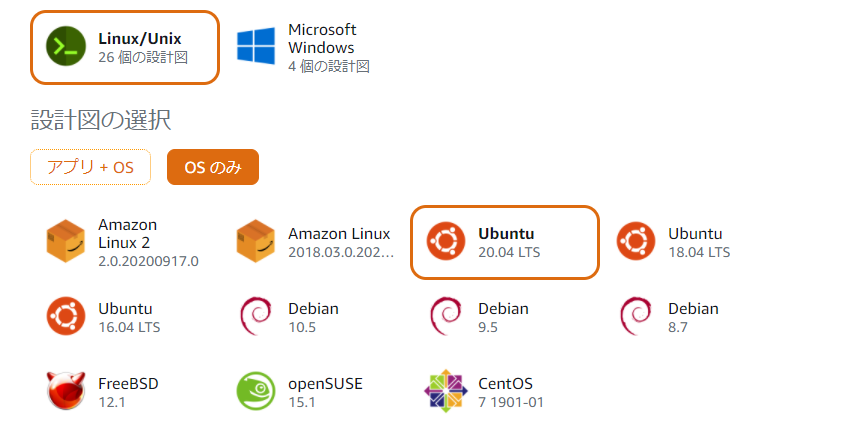

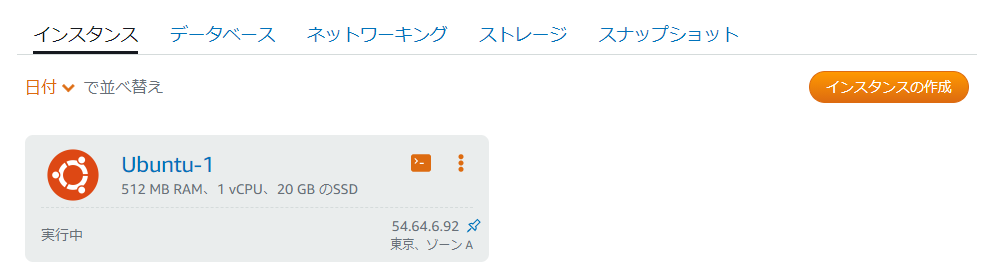

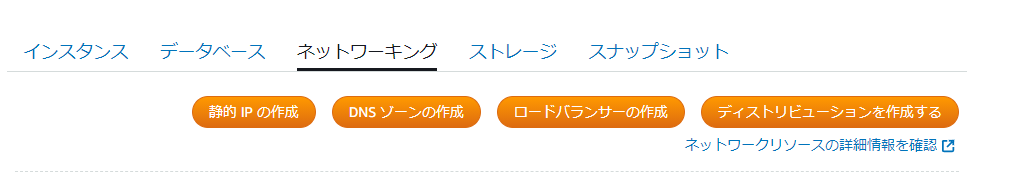

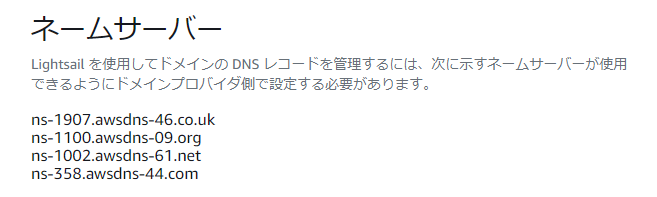

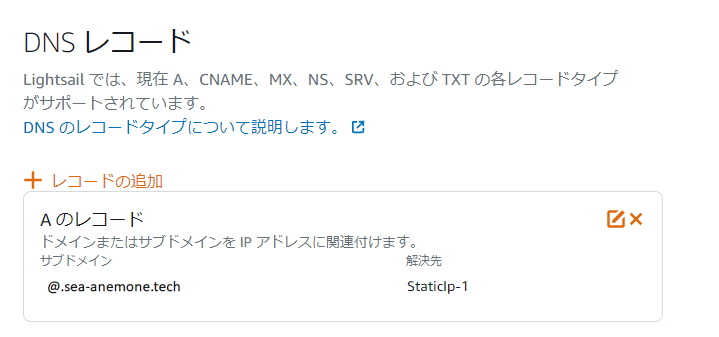

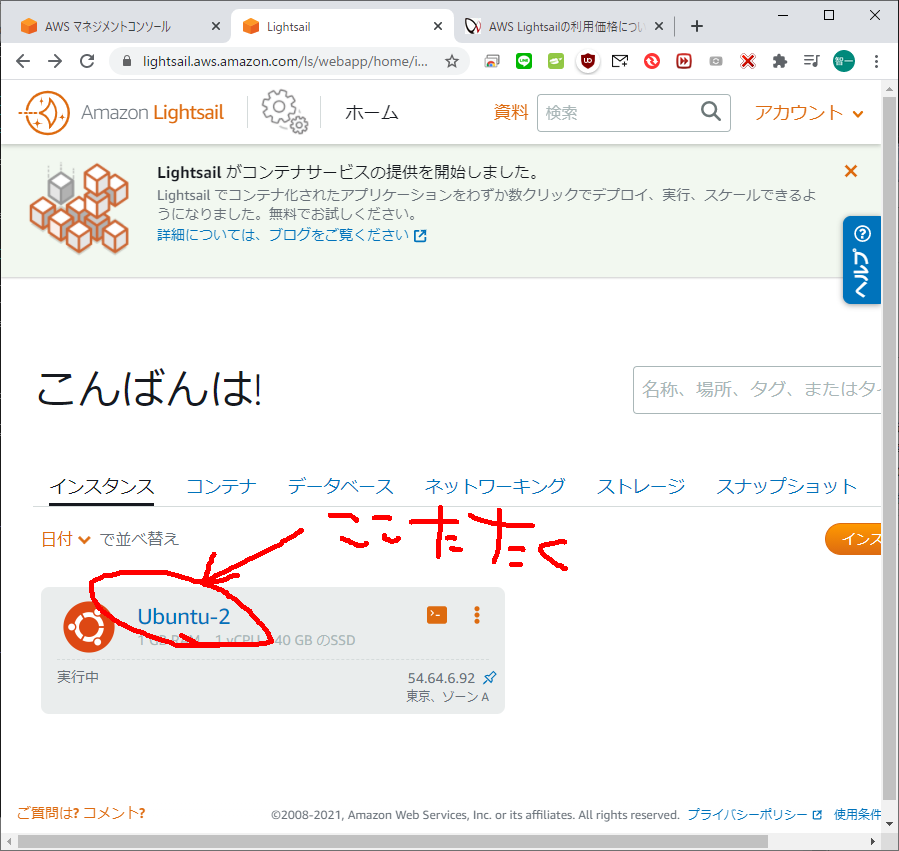

AWSは高価で設定が面倒くさいので、サーバ実装にはAmazon Lightsail(以下、Lightsail)を使っています。

Well, since AWS is expensive and troublesome to configure, I am using Amazon Lightsail (hereafter, Lightsail) for the server implementation.

先日、4月から高校生になる若者が「サーバを作りたい」と言っていたので、Lightsailを勧めたのですが、このLightsailの説明に、ちょっと悩みました。

The other day, a young person who will become a high school student next year said he wanted to build a server, so I recommended Lightsail, but I struggled a bit with how to explain it.

---

以前、今は亡き父と母に、メールシステムを教えることを試みて、それに失敗したのを覚えています。

I remember trying to teach my now-deceased father and mother about email systems and failing.

「メールシステムというのは、世界中のメールサーバを介してメールを配送するシステムで、メールが到着したサーバにアクセスすることで、メールを自分のパソコンに取り込むシステム」と言いながら ――

While saying, "An email system delivers messages via mail servers around the world, and by accessing the server where the mail arrives, you retrieve it to your own computer."

父と母が『全然分かりません』という表情をしていて、

My parents had expressions that said, "We don't understand at all,"

そして、私も『この説明では全然分からんだろう』と思いながら説明していました。

And I, too, was explaining while thinking, "This explanation won't make sense at all."

で、まあ、母に至っては、「やっぱり、智一(私)がアメリカから送るメールは時間がかかるのかねえ」といっていて ――

And my mother even said, "So emails you send from America take time to arrive, don't they?"

うん、たしかに、サーバをホップしていくので、それは時間がかかるとは思うけど、それは、「ミリ秒か遅くても秒の単位」だからと、母の認識は"正しく"、そして"間違っていた"のです。

Yes, it does hop across servers so that it might take time, but that time is in milliseconds or at most seconds, so her understanding was both "correct" and "incorrect."

あの時、私は、どのように、メールシステムについて、父と母に説明すべきだったのか、ChatGPTに聞いてみました。

At that time, I asked ChatGPT how I should have explained email systems to my parents.

ChatGPT:『メールは、「インターネットという道路網を通って、相手の近くにある受け取り用の箱まで運ばれる手紙」です。送るとネットワークの中を移動して相手専用の箱に入り、相手は自分のパソコンからその箱を見に行って取り出して読みます。』

ChatGPT: "Email is like a letter that travels through a road network called the Internet to a mailbox near the recipient. When sent, it moves through the network into the recipient's personal box, and they access it from their own computer to retrieve and read it."

「うーむ、ChatGPTでも"ダメか"」と感じました。

I felt, "Hmm, even ChatGPT can't solve this."

問題は、インターネットという概念を知らない人に、それを抜きに説明するのが、恐しく難しい、ということです。

The problem is that it is extremely difficult to explain something to someone who doesn't know what the Internet is.

---

しかし、こちらは、インターネットがもはや、生活インフラとなっている中学生です。この辺は困りませんでした。

However, in this case, we are dealing with a junior high school student for whom the Internet is already a daily part of their infrastructure, so this was not a problem.

私の原案は以下の通りです。

My original proposal was as follows.

■江端案(原案)

■Ebata Proposal (Original)Amazon Lightsailとは、世界中に配置されているデータセンタの中の一つ(今回は東京リージョン)の中で、24時間ずっと動き続ける自分用のPCのことです(シャットダウンしない)。

Amazon Lightsail is your personal PC that runs continuously, 24 hours a day, in one of the data centers located around the world (this time in the Tokyo region) (it does not shut down).このPCは、インターネットに直接つながっているので、そこで作ったプログラムは世界中の人から使用されます。

This PC is directly connected to the Internet, so programs created there can be used by people all over the world.このように24時間いつでも誰でも使えるプログラムのことを、「サーバー」と言います。

Such programs that are available to anyone, anytime are called "servers."つまりAmazon Lightsailとは、自分で作ったプログラムをサーバーとして世界中の人に使ってもらえる、Amazon社が提供するサーバー基盤のことです。

In other words, Amazon Lightsail is a server platform provided by Amazon that lets programs you create run as servers for people around the world.

これ(原案)に対するChatGPT案(校正案)は以下の通りです。

In response to this (original proposal), ChatGPT's revised proposals were as follows.

■ChatGPT案(その1)

■ChatGPT Proposal (1)Amazon Lightsailとは、世界中にあるAmazonのデータセンターの中で、24時間ずっと動き続ける「自分専用のコンピューター」を借りることができるサービスです(今回は東京にあるものを使います)。

Amazon Lightsail is a service that lets you rent your own dedicated computer that runs continuously, 24 hours a day, in Amazon's data centers around the world (this time we use one in Tokyo).このコンピューターはインターネットに直接つながっているため、そこで作ったプログラムを、世界中の人からアクセスできるようにすることができます。

Because this computer is directly connected to the Internet, programs created there can be accessed by people around the world.このように、インターネットを通して他の人が使えるように動いているコンピューターやプログラムのことを「サーバー」と呼びます。

Such computers or programs that operate so others can use them via the Internet are called "servers."つまりAmazon Lightsailとは、自分で作ったプログラムをインターネット上で公開し、他の人が使えるようにするためのコンピューターを提供してくれる、Amazonのサービスです。

In other words, Amazon Lightsail is an Amazon service that provides a computer for publishing your programs on the Internet so others can use them.

■ChatGPT案(その2)

■ChatGPT Proposal (2)Amazon Lightsailとは、インターネットの中に置ける「自分専用のゲームサーバー用マシン」のようなものです。

Amazon Lightsail is like your own dedicated game server machine that you can place on the Internet.たとえば、マインクラフトのマルチプレイサーバーを動かすには、ずっと電源が入ったままのパソコンが必要になります。しかも、そのパソコンはインターネットにつながっていて、友達がいつでもアクセスできる状態でなければなりません。

For example, running a Minecraft multiplayer server requires a computer that is always powered on and connected to the Internet so friends can access it at any time.でも、自分の家のパソコンを24時間つけっぱなしにするのは大変です。

But keeping your home computer on 24 hours a day is difficult.そこで使うのがAmazon Lightsailです。

That's where Amazon Lightsail comes in.これは、Amazonのデータセンターの中にある「ずっと動き続けているパソコン」を、自分専用に1台借りられるサービスです。

It is a service that lets you rent your own always-on computer in Amazon's data center.そのパソコンは最初からインターネットにつながっているので、そこにプログラムを置けば、世界中の人がアクセスできます。

Since that computer is already connected to the Internet, installing a program on it allows access from anywhere in the world.このように、みんながネット経由で使えるように動いている仕組みのことを「サーバー」と呼びます。

Such a mechanism that runs so everyone can use it over the network is called a "server."つまりAmazon Lightsailとは、

In other words, Amazon Lightsail is自分だけの「ネット上のゲームサーバー用PC」を借りて、そこに自分の作ったプログラム(たとえばAPI)を置き、スマホアプリやWebサイトから使えるようにできるサービスです。

a service that allows you to rent your own "game server PC on the Internet," place your own programs (such as APIs) on it, and make them usable from smartphone apps or websites.

---

うん、いずれも悪くはない、と思いました。

I thought that none of these were bad.

インターネットを理解していない世代と、理解している世代 ―― 説明の仕方も随分変わるものだなぁ、と実感しています。

I realized that the way explanations change greatly between generations who understand the Internet and those who do not.

もっとも「私の説明能力が、世代に関係なく常に不足している」という可能性も否定できませんが。

However, I cannot deny the possibility that my explanatory ability is always insufficient regardless of generation.

Amazon Web Service(AWS)の無料期間が経過していて、3~4回くらい、5000円/月の課金を喰らっていたことを知って、先日あわててアカウントを抹消しました。